Figura 1. Proceso de investigación en la Teoría Fundamentada

Revista Electrónica de Investigación Educativa

Vol. 16, Núm.

1, 2014

Teoría fundamentada y Atlas.ti: recursos metodológicos

para la investigación educativa

Daniel San Martín Cantero

dsanmartin2012@gmail.com

Facultad de Educación, Universidad Católica de Temuco

C.P. 4780000

Temuco, Chile

(Recibido: 11 de septiembre de 2012; Aceptado para su publicación:

20 de agosto de 2013 )

Resumen

Las prácticas investigativas en educación han experimentado muchos

cambios, principalmente en los procedimientos de análisis. Estos cambios

han sido motivados por la irrupción de la Teoría Fundamentada

en la práctica investigativa, pero también por la presencia de

software específico para análisis cualitativos de datos. Esta

situación no está exenta de cuestionamientos y debates en torno

al real aporte de los ordenadores en la investigación de tradición

interpretativa. Sin embargo, esto se debería al desconocimiento de la

relación método-software. En este trabajo se presentan los procedimientos

analíticos propuestos por la Teoría Fundamentada, y las posibilidades

que ofrece el software Atlas.ti para mejorar la práctica analítica

cualitativa. La finalidad es contribuir a la fundamentación teórico-metodológica

en la investigación educativa.

Palabras clave: Teoría fundamentada, Análisis de datos,

Investigación educativa, CAQDAS.

I. Introducción

Al igual que otras disciplinas científicas la investigación educativa

se ha visto influenciada por las tecnologías de la información,

principalmente en sus procesos de análisis. Este artículo explora

el vínculo entre Atlas.ti y Teoría Fundamentada (en adelante TF),

y se exponen las posibilidades que el software ofrece para desarrollar la TF.

Para ello, se revisan los principios orientadores de la construcción

teórica a partir del análisis de los datos haciendo uso de recursos

informáticos.

La incorporación de computadoras mediante programas informáticos

para la investigación educativa ha provocado, por una parte, esperanzas

respecto a las ventajas de utilizarlos, pero por otra ha generado inquietudes

y temores acerca del cambio que significa incorporar la tecnología en

los procesos de investigación (Flick, 2007). La utilización de

software en la investigación educativa incrementa la transparencia en

el proceso de análisis (Richards y Richards, 1994), pero lo más

importante es ser consciente que los CAQDAS1

son una herramienta al servicio de la tradición metodológica que

utilizan los investigadores. Por lo tanto, el uso de los programas para análisis

de datos cualitativos debe interpretar claramente los requerimientos metodológicos

del problema de investigación (Chernobilsky, 2009).

Así, en el contexto de la formación de pregrado y postgrado, se

observa confusión respecto del sentido que debe tener el análisis

de datos en la práctica investigativa. Confusión que impide reflexionar

acerca del componente relacional en el análisis de la realidad socioeducativa.

Por el contrario, existe una tendencia a fragmentar el conocimiento empírico.

Esto opera como un principio reduccionista de la ciencia que invisibiliza la

naturaleza sociocultural e histórica de la realidad (Morín, 1984).

Lo anterior es resultado de la formación en investigación educativa

de base positivista y neo-positivista, la cual ha rehuido el debate teórico

en torno a la importancia del carácter histórico y cultural de

los fenómenos sociales (Márquez, 2009). Esto también se

ha reflejado en el análisis de la realidad socioeducativa, en donde las

técnicas analíticas tienen como propósito la búsqueda

de regularidades, frecuencias y leyes absolutas, y no precisamente de una construcción

teórica. En este sentido, el estilo de análisis de la TF,

es decir, la teoría como indispensable para el conocimiento profundo

de los fenómenos sociales, constituye la mejor forma para representar

la realidad social, por cuanto la teoría surge (inductivamente) de los

datos (Andréu, García-Nieto y Pérez, 2007).

El objetivo de este artículo es exponer la importancia de la adecuación

entre el método y la técnica. Esto permitirá mostrar que

el vínculo TF y Atlas.ti es una condición

necesaria para mejorar y superar la práctica tradicional en análisis

de datos cualitativos.

Los investigadores más ortodoxos tienen una postura reticente al uso

de programas para el trabajo interpretativo, ven en el trabajo artesanal la

esencia del análisis cualitativo. Ciertamente los analistas pasaban largas

horas con los datos hasta el punto de alucinar o soñar con los mismos,

en este sentido la relación de quien investiga y los datos era íntima

y duradera. Sin embargo, existen tres tipos de analistas cualitativos: (1) los

que prefieren técnicas artesanales (lápices de colores, tijeras,

tarjetas, fichas, entre otros.), (2) los que optan por programas de cómputo

(procesadores de texto, hojas de cálculo, bases de datos, entre otros),

y (3) aquellos que prefieren el uso de programas específicos para el

análisis de datos (Cisneros, 2003).

Tesch (1990) fue el primero en distinguir entre programas para el análisis

descriptivo-interpretativo y otros para construir teorías. En la primera

clasificación se incorporaron: TAP, QUALPRO, HyperQual,

y Etnograph, en tanto para la elaboración de teoría son pertinentes

programas como: Aquad, Nudist, Hipersearch y Atlas.ti.

Es menester reconocer que el análisis de datos asistido por computadora,

independiente de la posición a favor o en contra, otorga cabida a distintas

tradiciones y diseños cualitativos. En este sentido se reconoce como

el primer programa para abordar el análisis del texto el General

Inquirer desarrollado en 1966, sin embargo el análisis que se realizaba

con este recurso más bien respondía a un análisis cuantitativo

del texto. Por esta razón el Etnograph, creado por Jhon Seidel, sería

un programa pionero para el análisis descriptivo-interpretativo de textos.

Este software fue diseñado alrededor de conceptos de descontextualización

y re-contextualización, por lo que realiza una serie de funciones entre

las que se destacan la búsqueda selectiva de segmentos codificados, y

la elaboración de frecuencias de códigos (Revuelta y Sánchez,

2005)

Más allá del desarrollo de los CAQDAS, en

este trabajo se abordarán aspectos epistemológicos y metodológicos

propios de la TF. Posteriormente se expondrán las

contribuciones del software Atlas.ti a los procedimientos propuestos por la

TF, pero también las potenciales desventajas que

puede traer su uso. Por último, se comparten algunas reflexiones respecto

de la importancia de la TF y Atlas.ti en la formación

y desarrollo de la investigación educativa.

II. Bases teóricas y metodológicas de la Teoría

Fundamentada

A lo largo de los últimos años la TF

ha ganado adeptos y espacios en la investigación educativa. Sin embargo,

en muchas ocasiones investigadores latinoamericanos declaran su utilización

sin lograr verdaderamente elaborar una teoría sustantiva. Esto ocurriría

por desconocimiento paradigmático y de los principios metodológicos

que orientan la TF.

La TF fue pensada y propuesta por Barney Glaser y Anselm

Strauss en las década de los 60. Sus inspiraciones para desarrollar esta

metodología estriban en la necesidad de salir al campo de investigación

para descubrir los conceptos que allí subyacen. Ambos investigadores

compartían la necesidad de hacer comparaciones constantes mientras se

hacían los análisis cualitativos, con la finalidad de desarrollar

conceptos y relacionarlos.

La TF hunde sus raíces en el interaccionismo simbólico

(Blumer, 1969). Por cuanto la comprensión (Verstehen) de los significados

construidos intersubjetivamente, se superpone a la explicación causal

(Erklären). En consecuencia, se intenta desarrollar interpretaciones del

mundo de los sujetos en función de sus propias interpretaciones, teniendo

como objeto de investigación la acción humana. De esto, se plantea

que somos amalgamas resultado de nuestras relaciones en y con el mundo; el mundo

siempre está con nosotros (Merleau-Ponty, 1962). Por lo tanto, la complejidad

del escenario investigativo en el contexto educativo, desafía a construir

conocimiento situado desde los sujetos y su mundo de vida.

Aceptar esta noción de una co-construcción intersubjetiva de la

realidad (Schutz, 2003) implica que refutemos el objetivismo crítico

que exige la ciencia positivista, por cuanto la dicotomía sujeto-objeto

se vuelve indefendible (Crotty, 2003). En este sentido, los sujetos de la investigación

educativa; profesores, estudiantes, padres, entre otros, no pueden ser descritos

independiente de nuestra relación con ellos.

En la TF los significados construidos intersubjetivamente

entre investigadores y participantes son fundamentales para teorizar respecto

de la realidad investigada. Precisamente, el propósito de la TF

es descubrir y desarrollar la teoría que se desprende del contexto

investigado, y no someterse a un razonamiento deductivo apoyado en un marco

teórico previo (Charmaz, 2007).

2.1 Teorización Sustantiva y Teorización Formal

Para establecer la importancia de las construcciones teóricas derivadas

de contextos particulares, y por lo tanto de problemas o áreas de interés

delimitados a ese contexto, Glaser y Strauss aluden al término teorización

sustantiva, que se contrapone al de teorización formal y se refiere al

desarrollo teórico de vasto alcance, caracterizado por leyes generales

e hipótesis comprobables en la realidad.

De este modo, el término Teorización Sustantiva alude al área

empírica, concreta y sustancial de la investigación. En el caso

de la educación, ejemplos de áreas sustantivas serían:

convivencia escolar en contextos interculturales, relaciones intersubjetivas

entre profesores experimentados y principiantes (San Martín y Quilaqueo,

2012), y conocimiento didáctico del profesor que se desempeña

en escuelas rurales, entre otras.

En cambio, la teorización formal está dirigida a un área

de indagación general y conceptual como: clima escolar, interculturalidad,

enseñanza, entre otros. Estas áreas generales se desarrollan más

allá del contexto; es decir, la generalización y comprobación

empírica son los principios que rigen a la teoría. En efecto,

teorizar es un proceso de construcción de teorías útiles

para comprender la realidad descrita y conceptualizada (Strauss y Corbin, 2002).

Por medio de la teorización sustantiva es posible cumplir con el criterio

de transferibilidad, que es una condición para la calidad de

la investigación educativa (Sandín, 2006). Este criterio garantiza

la aplicabilidad de resultados en contextos similares al de la investigación.

Dado que al delimitar las condiciones y características del contexto

en donde ocurre el fenómeno que se estudia, se incrementa la claridad

para identificar otros contextos similares en los cuales la teoría desarrollada

podría encajar. En síntesis, la teoría sustantiva da cuenta

de realidades humanas singulares porque se alimenta con procesos de recolección

de datos de la investigación en curso de una manera dinámica y

abierta (Sandoval, 1997). A diferencia de procedimientos deductivos de la teoría

formal o general, cuya preocupación está en la verificación

teórica, lo cual lleva a tener una perspectiva relativamente estática

y cerrada por su apego a la generalidad.

2.2 Características de quien trabaja con Teoría Fundamentada

El investigador que trabaja con TF es flexible, en tanto

es capaz de direccionar la investigación de acuerdo con las emergencias

del campo. Además de la flexibilidad metodológica,

el investigador recibe constructivamente las críticas de sus pares. Disfruta

del intercambio de ideas tanto sustantivas como teóricas,2

mas permanece distanciado de estas últimas, aun cuando sean atractivas;

excepto si están basadas en algún tipo de relación con

los datos.

Otra característica de quienes trabajan con TF

es la confianza que poseen acerca de su teoría, siempre esperan una buena

acogida por parte de la comunidad científica. Una última cuestión

es la sensibilidad teórica que poseen los investigadores para el trabajo

con esta metodología; mientras más sensibilidad con la pertinencia

teórica de ciertos conceptos, más probable es que se reconozcan

las dimensiones de estos conceptos en los datos (Strauss y Corbin, 2002).

Finalmente, las habilidades que los investigadores muestran

como resultado de la experiencia de trabajar TF son las

siguientes:

Sin duda, en el ámbito de la investigación educativa la actitud

de flexibilidad metodológica del investigador es clave para la comprensión

del fenómeno en estudio. Por cuanto las dinámicas de interacción,

omisiones, significados y experiencias que se expresan en el medio escolar,

demanda de la habilidad del investigador para estar atento a los giros metodológicos

necesarios para profundizar en el tema estudiado. En este punto, la sensibilidad

teórica es clave en el proceso investigativo (Strauss y Corbin, 2002)

porque sitúa al investigador como al principal instrumento de la investigación

(Taylor y Bogdan, 2000).

2.3 El método comparativo constante (MCC)

Es un método para interpretar textos, que se transforma en un método

comparativo constante cuando se comparan una y otra vez, de manera

sistemática, los códigos con los nuevos obtenidos. Es decir, al

mismo tiempo que se codifica se analiza para elaborar conceptos, mediante comparaciones

constantes de ocurrencias específicas de los datos, “…el

investigador refina esos conceptos, identifica sus propiedades, explora sus

interrelaciones y los integra en una teoría coherente” (Taylor

y Bogdan, 2000, p. 155).

Dado que el objetivo de este artículo no es profundizar en el MCC,

tarea que se realizará en un próximo trabajo, se presentan algunos

procedimientos analíticos del MCC, para efectos

de exponer la lógica que lleva a la construcción teórica

en la TF. En consecuencia, se presentan las cuatro etapas

más relevantes para el análisis constructor de teoría (Flick,

2007): (i) comparación de incidencias aplicables a cada categoría,

(ii) integración de las categorías y sus propiedades, (iii) delimitación

de la teoría, y (iv) redacción de la teoría.

Además, y para efectos de aproximarse a una conceptualización

del MCC, Valles (1997) realiza una diferenciación

entre la Inducción Analítica (IA) de Znaniecki,

y el MCC.

2.4 Codificación abierta de datos: iniciando el análisis

constructor de teoría

Normalmente, el análisis de datos cualitativos, representa una zona desconocida

en la publicación referida a metodología. Esto se debe a que no

se explicitan, con la suficiente claridad, los procedimientos utilizados para

el análisis realizado. Para el caso de la aplicación de la TF,

la codificación teórica es el principal procedimiento de análisis

para construir teoría. En este procedimiento de interpretación

de datos se pueden distinguir tres procesos: codificación abierta,

codificación axial y codificación selectiva.

Se denomina codificación abierta al proceso de abordar el texto, con

el fin de desnudar conceptos, ideas y sentidos. Respecto a esto Strauss y Corbin

(2002) son claros señalando que “para descubrir y desarrollar los

conceptos debemos abrir el texto y exponer los pensamientos, ideas y significados

contenidos en él” (Strauss y Corbin, 2002, p. 111). Este trabajo

es profundamente inductivo, ya que prescinde de una teoría para aplicar

conceptos, leyes o dimensiones al texto que se está codificando.

La codificación abierta resulta del examen minucioso de los datos para

identificar y conceptualizar los significados que el texto contiene. Los datos

son segmentados, examinados y comparados en términos de sus similitudes

y diferencias. Estas comparaciones deben quedar registradas en anotaciones (memos)

que acompañen a cada código (Charmaz, 2007). Es importante agregar

que existen dos tipos de códigos: abiertos e in vivo. Los primeros

conceptualizan el fenómeno a través de la interpretación

del analista, en cambio los segundos son frases literales que expresan las palabras

usadas por los individuos.

El resultado de la primera codificación es una lista de códigos

de la que, al compararlos respecto de sus propiedades, dimensiones y significados,

se obtiene una clasificación, mayor o de segundo grado, denominada categoría.

A este proceso de le denomina categorización, y se refiere al resumen

de conceptos en conceptos genéricos (Flick, 2007).

2 .5 Vinculando categorías mediante la Codificación Axial

La codificación axial es el proceso de identificación de relaciones

entre las categorías obtenidas en la Codificación Abierta y sus

subcategorías, esta relación está determinada por las propiedades

y dimensiones de las subcategorías y categorías que se quieren

relacionar, teniendo en cuenta que “una categoría representa un

fenómeno, o sea, un problema, un asunto, un acontecimiento o un suceso

que se define como significativo para los entrevistados” (Strauss y Corbin,

2002, p. 137). Strauss y Corbin también definen las tareas involucradas

en la Codificación Axial:

Además de lo anterior Flick (2007) se refiere al paradigma de codificación

elaborado por Strauss y Corbin (2002), el que guiará la relación

entre categorías y subcategorías. En éste se propone realizar

preguntas a los datos (códigos, categorías y subcategorías),

en términos de las condiciones, fenómeno, contexto, condiciones

interpuestas, estrategias de acción e interacción y consecuencias

entre categorías.

Lo anterior, da paso a una serie de pequeñas historias expresadas en

las relaciones descubiertas entre los datos:

(…) una explicación cuenta una historia sobre las relaciones entre las cosas o las personas y los acontecimientos. Para narrar una historia compleja, uno debe designar losacontecimientos, plantear o implicar sus dimensiones y propiedades, proporcionarles un contexto, indicar una o dos condiciones de cualquier acción/interacción que sea esencial para la historia, y señalar o deducir una o más consecuencias (Schatzman, 1991, p. 308).

Las instuiciones iniciales respecto de la relación entre categorías

y subcategorías se expresan en hipótesis que explican el qué,

por qué, dónde y cómo de un fenómeno. En este punto,

el análisis que lleva a la teorización del caso se complejiza,

por esta razón conviene generar diagramas explicativos haciendo uso de

Atlas.ti, cuyas ventajas se explicarán más adelante. Los diagramas

o redes entre los conceptos permiten esclarecer las relaciones, mostrar los

contextos y levantar una serie de proposiciones en torno al tema de investigación.

Es una condición para la construcción de la teoría, que

las hipótesis iniciales se validen a través de la comparación

con los datos. Esto dará paso a la integración de las categorías

en una categoría central que expresa el fenómeno en estudio.

2.6 Codificación Selectiva: el núcleo de la teoría

Este es el tercer paso en el proceso de codificación teórica,

aunque no es una etapa independiente de la codificación abierta y axial,

sino una extensión de esta última, pero con un mayor nivel de

abstracción. El propósito de esta codificación es obtener

una categoría central que exprese el fenómeno de investigación

e integre las categorías y subcategorías de la codificación

abierta y axial. Entonces, la categoría central “consiste

en todos los productos del análisis, condensados en unas cuantas palabras

que parecen explicarnos de qué trata la investigación” (Strauss

y Corbin, 2002). En este proceso el analista tiene un conjunto de categorías

y subcategorías que convergen en una unidad conceptual, que a su vez

integra la realidad expresada por todos los sujetos de la investigación.

Las relaciones entre las categorías y la categoría central están

dadas por frases que no necesariamente deben ser hipótesis o preposiciones

explícitas sino que, pueden estar implícitas en la narración

de la teoría. Previo a esto, es importante tener una descripción

clara y gráfica de la teoría, que sintetice los principales conceptos

y sus conexiones, sólo entonces se estará en condiciones de presentar

el relato del caso (Charmaz, 2007).

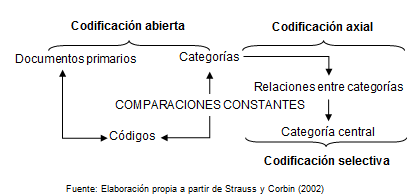

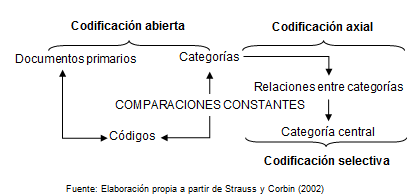

En la figura 1 se sintetizan las fases analíticas de la TF

en el marco de un proceso recursivo, proceso que también es característico

de los métodos cualitativos, y está orientado por comparaciones

constante entre los datos, códigos, categorías y subcategorías.

Figura 1. Proceso de investigación en la Teoría Fundamentada

Es preciso señalar que existen

criterios claros para determinar la función y determinación de

la categoría central, así como también, para integrar las

categorías y subcategorías a la categoría central, temas

en los que se profundizará en trabajos posteriores.

2.7 Saturación de datos: hacia la estabilidad de la teoría

Uno de los procedimientos analíticos que asegura la riqueza explicativa,

y de relaciones teóricas entre categorías, es la saturación

teórica o de contenido. Si el investigador no recopila

datos hasta saturar todas las categorías, la teoría no se desarrollará

equilibradamente y carecerá de densidad y precisión. Además,

la saturación permite identificar el momento en que es necesario detener

la recolección de datos (Strauss y Corbin, 2002).

En el instante en que las comparaciones constantes entre los datos no evidencian

nuevas relaciones o propiedades de los datos; la riqueza que representan los

datos se comienza a agotar. En ese momento se evidencia la saturación

teórica, donde el muestreo teórico comienza a definir su

término, por lo tanto no es conveniente realizar más entrevistas

y observaciones. Los datos comienzan a tornarse repetitivos y no se obtiene

nada nuevo: “El muestreo e integración de material nuevo se acaba

cuando la saturación teórica de una categoría o grupo de

casos se ha alcanzado, es decir, cuando no emerge ya nada nuevo” (Flick,

2007, p. 79).

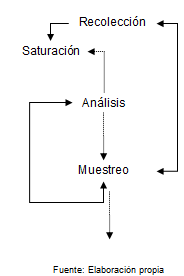

Mediante la Figura 2 se intenta mostrar el modelo circular del análisis

cualitativo, circularidad que tienen como eje central el análisis de

los datos, en torno al cual giran procedimientos como: muestreo teórico,

saturación y el trabajo de recolección de información.

Figura 2. Modelo circular en el análisis cualitativo

Para lograr la saturación

de los datos, es necesario que el investigador sea paciente, es decir, es preferible

esperar atentamente la emergencia de la teoría. Para esto, el analista

no debe dejar de hacer preguntas a los datos, para así probar la estabilidad

conceptual de los mismos, y asegurarse de que el concepto teórico ha

logrado un estado adecuado de desarrollo.

III. El caso de Atlas.ti y su relación con la TF

Para comprender la relación entre Atlas.ti y TF

conviene recordar el principio de los métodos interpretativos, el cual

plantea que un investigador no comienza su trabajo con una teoría preconcebida,

excepto si quiere desarrollar una ya existente. Por el contrario, sugiere que

los conceptos e hipótesis sean elaborados a partir de los datos, y con

ellos a lo largo de la investigación. Se reconoce como rasgo fundamental

de este enfoque metodológico el carácter circular del proceso

(Flick, 2007), esto obliga al investigador a reflexionar sobre el proceso completo

de la investigación a raíz de los nuevos pasos mostrándose

un claro vínculo entre recogida e interpretación de datos, y selección

de material empírico.

Atlas.ti el principal soporte informático para desarrollar TF,

este programa fue diseñado a finales de los ochenta por el alemán

Thomas Murh, quien recurriendo a la tecnología hizo un intento por aplicar

los planteamientos metodológicos de Glaser y Strauss. Este software permite

expresar el sentido circular del análisis cualitativo, por cuanto otorga

la posibilidad de incorporar secuencialmente los datos, sin la necesidad de

recoger todo el material en un mismo tiempo. Por esta razón, permite

llevar a cabo el muestreo teórico necesario para realizar el análisis

constructor de teoría.

Asimismo, Atlas.ti permite identificar aquellos códigos que requieren

ser saturados, esto es posible a través de la función code-primary-documents-table

(códigos-documentos primarios-tablas), que muestra la cantidad de citas

que cada código tiene. Por tanto, esta función del software facilita

la aplicación de la saturación de contenido de cada código

y categoría, tal como se propone en la TF.

Al igual que la generalidad de los programas informáticos, Atlas.ti es

un programa de recuperación de texto, sin embargo está dirigido

a un trabajo conceptual, en donde cada paso de la codificación teórica

(codificación abierta, axial y selectiva) tiene un espacio en el programa.

Por ejemplo, la codificación abierta se realiza en el nivel de codificación

de segmentos, ya sea de texto, audio, video o imágenes. En tanto, la

codificación axial tiene su espacio con la función de creación

redes de relaciones conceptuales. Son esquemas explicativos, pero no jerárquicos,

de las categorías y sus subcategorías en función de las

relaciones entre familias de códigos o anotaciones (Weitzman y Miles,

1995). En cuanto, a la codificación selectiva propuesta en la TF,

Atlas.ti posee la función súper código, que permite

elaborar una categoría central que integra los códigos y categorías

construidos en las fases de codificación abierta y axial.

La última versión de Atlas.ti permite trabajar en línea

transformando los análisis en páginas htlm para ser subidas al

ciberespacio, esto admite que sea posible realizar codificaciones colaborativas,

y aplicar el criterio de triangulación de investigadores.

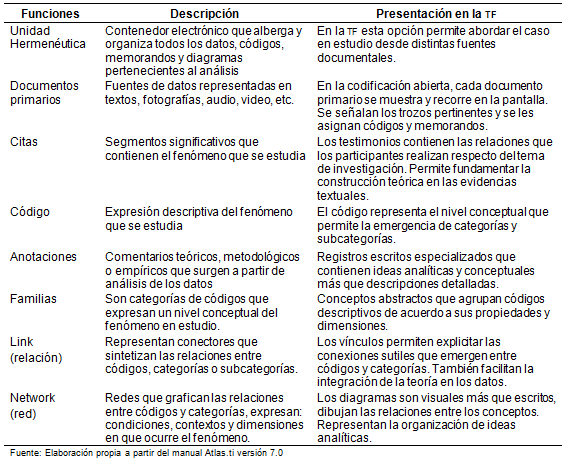

Es importante comprender el uso metodológico de Atlas.ti en relación

a la TF, por esta razón en la tabla I se sintetiza

la coherencia entre software y método. La finalidad de las principales

funciones del programa es acoger los procedimientos constructores de teoría.

En este sentido facilita la organización del análisis a través

de funciones que permiten: segmentar citas, conceptualizar, registrar reflexiones,

categorizar, relacionar procesos y mostrar la teoría que se construye

a través de diagramas. Todos estos procedimientos de primer y segundo

orden, otorgan al análisis mayor poder explicativo para la investigación

educativa.

Tabla I. Correspondencia

entre funciones de Atlas.ti y procedimientos de la TF

3.1 Ventajas del uso de Atlas.ti

Al incorporar programas para análisis de datos, aumenta la calidad de

la investigación educativa, puesto que fortalece la coherencia y el rigor

de los procedimientos analíticos (Weitzman, 2000; Seale, 1999). Principalmente,

se reconocen como ventajas la rapidez que otorga a procesos mecánicos

como: segmentación, recuperación y codificación

de información (Amezcua y Gálvez, 2002).

Metodólogos, como Valles (2002), establecen claras ventajas y desafíos

del análisis cualitativo asistido por computador, como por ejemplo: el

ahorro de tiempo. Al respecto Flick (2007) destaca la velocidad en

la gestión, búsqueda y exposición de los datos y códigos.

Esto representa una tremenda ventaja cuando el investigador se enfrenta a grandes

cantidades de datos y permite reflexionar sobre el actuar de algunos investigadores,

que al no incorporar los CAQDAS se obligan a diseñar

limitados instrumentos de recolección de datos, debido a la escasez de

tiempo con la cuentan en sus proyectos de investigación en educación.

Otra ventaja es la codificación y exploración

de datos, que implica marcar fragmentos de texto para luego codificarlos y obtener

un listado de códigos descriptivos. Por otra parte, la codificación

y los fragmentos del texto pueden ser complementados con notas de campo o anotaciones

(memos), lo que posibilita la incorporación de ideas o reflexiones teóricas

del investigador-analista.

La inclusividad es otra capacidad considerada como una ventaja de programas

para análisis cualitativo. De acuerdo con Seale (1999) los programas

inclusivos son aquellos que admiten datos de distinta naturaleza, tales como:

entrevistas, notas de campo a partir de la observación, videos, periódicos,

memorandos, manuales, catálogos y otras modalidades de materiales pictóricos

o escritos.

También, a raíz del trabajo inter-subjetivo entre miembros del

equipo de investigación, el control y auditoría supone una ventaja

gracias a la facilidad que se le otorga al trabajo simultáneo de investigadores.

Algunos, CAQDAS como Atlas.ti ofrecen la posibilidad de

emprender proyectos en donde varios analistas trabajen de manera simultánea

con distintos perfiles de usuario, permitiendo el trabajo en línea con

investigadores de otras latitudes. Esto se traduce en un aumento de transparencia,

debido al fortalecimiento de la comunicación online del equipo de investigación

(Flick, 2007, p. 267).

Respecto de la visualización de los datos han sido mayores los aportes

al trabajo de análisis tradicional que se ha realizado hasta antes de

la irrupción de la tecnología en la investigación cualitativa.

De esta manera existen programas que permiten trazar gráficos para dar

a conocer relaciones complejas del fenómeno en estudio, o también

esquematizar árboles de conceptos que poseen ciertas jerarquías

sobre otros. Para esto, los programas mejor equipados como: Atlas.ti y Nudist

NVivo, permiten trazar redes conceptuales para facilitar la elaboración

de modelos teóricos, y escritura de los hallazgos (Valles 2002).

Los mejores programas para análisis cualitativo de datos facilitan la

construcción de teorías por medio de la representación

de los datos en mapas gráficos, diagramas o esquemas jerárquicos

o relacionales (Flick, 2007). Además facilitan el nivel analítico

del trabajo con los datos por medio de memos que permiten reflexionar respecto

a las relaciones entre conceptos, y así construir las categorías

que darán cuerpo a la teoría.

Pese a lo anterior, el uso de CAQDAS no garantiza la presencia

de todas las ventajas durante el proceso analítico, dado que la destreza,

formación, experiencia, creatividad, de quien investiga es clave para

el éxito en la construcción de la teoría, o por el contrario

para el fracaso. Esto último, permite que se desarrollen múltiples

inconvenientes en el uso de CAQDAS, como los descritos

a continuación.

2.2 Principales inconvenientes en la utilización de Atlas.ti

Los principales inconvenientes del uso de Atlas.ti se relacionan con interpretaciones

equivocadas de las funciones del programa. En particular, se tiende a pensar

que este software puede realizar la tarea interpretativa propia de los análisis

cualitativos, y que representa un ejercicio intelectual de investigadores.

Otro inconveniente es el sesgo que produce insistir en el uso de un único

programa informático. Esto se transforma en un inconveniente cuando los

investigadores no consideran que deba existir una adecuación entre el

software y el método o diseño que requiere el problema de investigación.

Es decir, fuerzan la utilización del uso de un programa en particular,

sólo por el nivel de conocimiento que se tiene del software, o simplemente

porque consideran que agiliza el proceso de reducción de la información.

En consecuencia, es recomendable acceder a la variedad de programas que existen

actualmente, para poder comparar y selecciona el más conveniente para

el trabajo de análisis que demanda el método y el problema de

investigación.

Autores como Amezcua y Gálvez, (2002, p. 433) advierten “sobre

las grandes limitaciones que entraña el análisis asistido por

ordenador, como por ejemplo el fraccionamiento de la información, la

pérdida de la visión de conjunto y la descontextualización”.

Esto se fundamenta en el riesgo de perder la visión holística

del fenómeno en estudio, causada por el ejercicio constante de fraccionamiento

de los datos. Además, existe la posibilidad de quedar atrapado por la

seducción de la herramienta, limitando su uso a simples operaciones mecánicas

carentes de reflexividad y construcción teórica (Amezcua y Gálvez,

2002).

Una voz autorizada para referirse al uso de CAQDAS para

la construcción de teoría, es Barney Glaser, quien en el seminario

Investigación Avanzada Cualitativa Asistida por Ordenador realizado el

2001 en Andalucía, expuso acerca de la Grounded Theory. Sin

embargo, desató la polémica cuando se refirió a la importancia

de los computadores para la TF, al declarar:

Los ordenadores vuelven a poner lo cualitativo en lo cuantitativo (…) los ordenadores ignoran la saturación de conceptos y sus propiedades (…) pueden ser útiles en el análisis de datos cualitativos, donde la investigación va preconcebida, pero no en la grounded theory (GT) por su incompatibilidad e ineficacia (…) son un malgasto de recursos y esfuerzos del investigador, la GT funciona más rápido (Valles, 2001).

A partir de ese momento muchos investigadores

partidarios del análisis cualitativo asistido por computadora acusan

a Glaser de ultra ortodoxo, quien critica a los tecnólogos de no conocer

en profundidad aspectos metodológicos de la TF.

No obstante, para comprender este debate es importante despejar algunas dudas

que se asocian al aporte de las herramientas mencionadas. Una de estos malentendidos

es explicado por el metodólogo alemán Uwe Flick (2007) al afirmar

que los CAQDAS no hacen el análisis de una forma

automática, como el SPSS (Paquete Estadístico

para las Ciencias Sociales) realiza una operación estadística

o un análisis factorial. Por consiguiente, no se debe igualar a Atlas.ti

con programas estadísticos que operan matemáticamente con fórmulas

aplicadas a variables. (Dohan y Sánchez-Jankowski, 1998). Por tanto,

la reflexión final es entender que no hay algoritmo alguno para determinar

el círculo hermenéutico, ni cálculo matemático posible

que sature el análisis de un significado.

IV. Reflexiones finales

Más allá de la dimensión técnica que se utilice

en la investigación de la realidad socioeducativa, conviene preguntarse:

¿qué hace el investigador para evidenciar su posición epistemológica

en el marco de investigaciones educativas? Es decir, sorprende cuando en las

investigaciones educativas, expertos hacen uso de la técnica, sin mostrar

verdaderamente su linaje epistemológico. Al parecer, no se visualiza

la epistemología que sustenta al método, o al recurso informático

que se usa para el análisis de los datos.

La situación anterior, sin duda, reduce a los actores del contexto escolar

en meros sujetos de experimentación, por cuanto investigadores no expresan

en los diseños de investigación su identidad epistemológica,

o en palabras de Tello (2012), el enfoque episte-metodológico. Por el

contrario, usan Atlas.ti por simple moda, sin reconocer el vínculo que

tiene este programa con la TF. Como consecuencia, se observan

resultados “en esencia, descriptivos y teóricamente inestables

(…) no producen mucho conocimiento nuevo ni información rigurosa

o teorías sólidas” (Thöening, 2004, p. 189).

Por ello, en el contexto de investigación educativa es necesario que

se expliciten los procedimientos de análisis sin olvidar que los resultados

deben responder a construcciones teóricas que permitan comprender el

objeto de estudio. Zemelman ya advertía que en la investigación

social de Latinoamérica, “existe un desequilibrio entre el notable

desarrollo tecno-metodológico y el escaso desenvolvimiento del pensamiento

abstracto a través de la epistemología” (Zemelman, 1998,

p. 123).

Ciertamente la corriente constructivista de la TF (Charmaz,

2007) permite superar la noción de ciencia moderna, que concibe el conocimiento

como dividir y clasificar la realidad para la formulación de leyes generales

(Santos, 1987). Por el contrario, en la TF el investigador

es uno de los instrumentos de la investigación, además de ser

parte de la misma. En ese sentido, desempeña su rol investigativo desde

el lugar socio-histórico en el cual se encuentra y a partir de las relaciones

subjetivas que estableció con los sujetos (Chaluh, 2012). Tanto el sujeto

como el investigador reflexionan, aprenden y se re-significan en el proceso

de la investigación.

Es importante formar investigadores para el contexto educativo que superen toda

racionalidad instrumental y oportunismo metodológico (Horkheimer, 1969)

que se ha instalado en la ciencias sociales y de la educación. Racionalidad

expresada en la idea del uso de Atlass.ti como un recurso que garantiza la comprensión

de la realidad socioeducativa, y que por este hecho, las construcciones teóricas

de los resultados de una investigación, adquieren una incuestionable

validez. En consecuencia, el investigador de contextos educativos debe ser formado

en la coherencia recurso informático-método.

Sin lugar a dudas, Atlas.ti es uno de los programas más potentes para

el análisis de datos cualitativos, y que aporta a la construcción

teórica en la investigación educativa. Puesto que al permitir

la integración de datos de distinta naturaleza (texto, audio, video e

imágenes) recoge la diversidad que expresa la realidad socieducativa.

Así, es posible superar el nivel descriptivo para alcanzar el nivel conceptual

que contribuye a la teorización en el campo de la investigación

educativa. Además, la formación de estudiantes en el uso de este

software en coherencia con la TF, permite desvelar ese

lado oculto de la práctica investigativa que es el análisis de

datos, ya que muchas veces el análisis constituye la caja negra de la

práctica investigativa.

Asimismo, es imperante debatir acerca del rol de investigadores y sujetos en

la co-construcción de la teoría por medio del análisis

de datos asistido por software, labor que requiere un conocimiento profundo

del objeto de estudio, sensibilidad teórica, creatividadad y reflexión

constante. Esto signifca entender el método y la técnica, a partir

de una ontología que asume la realidad desde una perspectiva comprensiva,

y participativa-intersubjetiva entre sujetos e investgadores, superando así

la racionalidad instrumental presente en la investigación educativa.

Referencias

Amezcua, M. y Gálvez, A. (2002). Los modos de análisis en investigación

cualitativa en salud: perspectiva crítica y reflexiones en voz alta.

Revista Española de Salud Pública, 76, 423-436.

Ander-Egg, E. (1995). Técnicas de investigación social.

Buenos Aires: Lumen.

Andreu, J., García-Nieto, A. y Pérez Corbacho, A. (2007). Evolución

de la teoría fundamentada como técnica de análisis cualitativo.

Madrid: CIS.

American Psychological Association. (2006). Manual de estilo de publicaciones

de la American Psychological Association (3a. ed.). México: Manual

Moderno.

Bachelard, G. (1974). La formación del espíritu científico.

Buenos Aires: Siglo XXI.

Blumer, H. (1969). Symbolic Interactionism. Perspective and Method.

Los Ángeles, CA: University of California Press.

Chaluh, L. N. (2012). Investigar en la escuela: reflexiones teórico-metodológicas.

Revista Electrónica de Investigación Educativa, 14(1),

86-105. Recuperado de http://redie.uabc.mx/index.php/redie/article/view/298/684

Charmaz, K. (2007). Constructing grounded theory. A practical guide through

qualitative analysis. Thousand Oaks, CA: Sage.

Chernobilsky, L. (2009). El uso de la computadora como auxilizar en el análisis

de datos cualitativos. En I. Vasilachis, Estrategias de investigación

cualitativa (pp. 239-273). Barcelona: Gedisa.

Cisneros, C. (2003). Análisis cualitativo asistido por computadora. Sociologías,

9(5), 307.

Coffey, A. y Atkinson, P. (2003). Encontrar el sentido a los datos.

Antioquia: Universidad de Antioquia.

Creswell. (1998). Qualitative inquiry and research design. Choosing

among five traditions. California: Sage.

Crotty, M. (2003). The foundations of social research: Meaning and perspective

in the research process. Thousand Oaks, CA: Sage.

Dewey, J. (1934). Art as experience. Nueva York: Minton Blach.

Dohan, D. y Sánchez-Jankowski, M. (1998). Using computers to analyze

ethnographic field data: Theoretical and practical considerations. Annual

Reviews Sociology, 24, 477-498.

Flick, U. (2007). Introducción a la investigación cualitativa.

Madrid: Sage.

Gibbs, G. (2009). Analyzing qualitative data (1a. ed.). Londres: Sage.

Guba, E. y Lincoln, Y. (2000). Paradigmas en competencia en la investigación

cualitativa. En C. Denman y J. Haro, Por los rincones. Antología

de métodos cualitativos en investigación social (pp.113-145).

Colegio de Sonora.

Horkheimer, M. (1969). Crítica de la razón instrumental.

Buenos Aires: Sur.

Knoblauch, H., Flick, U. y Maeder, C. (2005). Qualitative methods in Europe:

the variety of social research. Ponencia presentad en el foro Qualitative

Social Research. Reino Unido.

Kuhn, T. (2004). La estructura de las revoluciones científicas.

México: Fondo de Cultura Económica.

Márquez, E. (2009). La perspectiva epistemológica cualitativa

en la formación de docentes en investigación educativa. Revista

de Investigación, 66, 13-35.

Marshall, C. y Rossman, G. (1995). Designing qualitative research.

Thousand Oaks, CA: Sage.

Merleau-Ponty, M. (1962). Phenomenology of perception. Nueva York:

Humanities Press.

Morín, E. (1984). Ciencia con conciencia. Pensamiento crítico/Pensamiento

utópico. Barcelona: Anthropos.

Quilaqueo, D., Fernández, C. y Quintriqueo, S. (2010). Interculturalidad

en contexto mapuche. Neuquén, Argentina: EDUCO.

Quilaqueo, D., Quintriqueo, S. y San Martín, D. (2011). Contenido de

aprendizajes educativos mapuches para el marco conceptual de un currículum

escolar intercultural. Estudios Pedagógicos, 37(2),

233-248.

Revuelta, F. I. y Sánchez, M. C. (2005). Programas de análisis

cualitativo para la investigación en espacios virtuales de formación.

Teoría de la Educación. Educación y Cultura en la Sociedad

de la Información. Recuperado de http://campus.usal.es/~teoriaeducacion/rev_numero_04/n4_art_revuelta_sanchez.htm

Richards, T. y Richards, L. (1994). Using computers in qualitative research.

En N. Denzin y Y. Lincoln, Handbook of Qualitative Research. Londres:

Sage.

Sandoval, C. (1997). Investigación cualitativa. Santa Fe de

Bogotá: Corcas.

San Martín, D. (2011). Actos pedagógicos profesor principiante.

Aletheia Mayor, 3. 67-100.

San Martín, D. y Quilaqueo, D. (2012). Habitus profesional y relaciones

intersubjetivas entre profesores principiantes y experimentados. Perfiles

Educativos, 34(136), 63-78.

Sandín, M. (2006). Retos actuales de la formación en investigación

cualitativa en educación. I Encuentro Internacional de Investigación

Cualitativa en Educación. Barquisimento, Venezuela: Educare.

Santos, B. (1987). Um discurso sobre as Ciências [Un Discurso

sobre las ciencias]. Secretaría Municipal de Educación de Campinas.

Brasil: Edições Afrontamento.

Schatzman, L. (1991). Dimensional analysis: Notes on an alternative approach

to the grounding of theory in qualitative research. En D. Maines, Social

organization and social process (pp. 303-314). Nueva York: Aldine de Gruyter.

Schutz, A. (2003). El problema de la realidad social. Escritos I. Buenos

Aires: Amorrortu.

Seale, C. (1999). The quality of qualitative research. Londres: sage.

Strauss, A. y Corbin, J. (2002). Bases de la investigación cualitativa.

Técnicas y procedimientos para desarrollar la Teoría Fundamentada.

Medellín: Universidad de Antioquia.

Taylor, S. y Bogdan, R. (2000). Introducción a los métodos

cualitativos (3a. ed.). Barcelona: Paidós.

Tello, C. (2012). Las epistemologías de la política educativa:

vigilancia y posicionamiento epistemológico del investigador. Práxis

Educativa, 7(1). 53-68.

Tesch, R. (1990). Qualitative research. Analysis types and software tools.

Basingstoke, Inglaterra: Falmer Press.

Thöening, J. C. (2004). La actualización del conocimiento en el

campo de la administración y las políticas públicas. En

M. Pardo, De la administración pública a la gobernanza

(pp. 183-216). El Colegio de México.

Valles, M. (2001). Ventajas y desafíos del uso de programas informáticos

(p.e. Atlas.ti y MAXqda) en el análisis cualitativo. Una reflexión

metodológica desde la grounded theory y el contexto de la investigación

social española. Seminario sobre Investigación Avanzada Cualitativa

Asistida por Ordenador (pp. 1-26). Granada: Fundación de Centros de Estudios

Andaluces.

Weitzman, E. y Miles, M. (1995). Computer programs for qualitative data

analysis. Thousand Oaks, CA: Sage.

Zemelman. (1998). Crítica, epistemología y educación. Revista

de Tecnología Educativa, 2(13), 119-131.

1CAQDAS

es el acrónimo de Computer Assisted Qualitative Data Software, hace referencia

a software para el análisis cualitativo de datos asistido por ordenador.

2Strauss

al referirse a los términos sustantivo y teórico o formal, dan

cuenta del estado y origen del fenómeno. En el primer caso, apela a lo

que emerge de las personas en tanto no ha sido redefinido ni conceptualizado

rigurosamente. El segundo caso está asociado a la rigurosa definición

conceptual que permite el tránsito de lo sustantivo hacia un nivel teórico

o formal.

3Tomado

de Bases de la investigación cualitativa. Técnicas y procedimientos

para desarrollar Teoría Fundamentada (Strauss y Corbin, 2002, p. 8).

Para

citar este artículo, le recomendamos el siguiente formato:

San Martín, D. (2014). Teoría fundamentada y Atlas.ti: recursos

metodológicos para la investigación educativa. Revista Electrónica

de Investigación Educativa, 16(1), 103-122. Recuperado

de http://redie.uabc.mx/vol16no1/contenido-sanmartin.html