Tipos de retroalimentación para la lectura estratégica en clases masivas

Cómo citar: Colmenares, L., Torres-López, G. Y. y Santoyo, C. (2025). Tipos de retroalimentación para la lectura estratégica en clases masivas. Revista Electrónica de Investigación Educativa, 27, e19, 1-15. https://doi.org/10.24320/redie.2025.27.e19.6171

Resumen

La retroalimentación es indispensable para el desarrollo de habilidades durante la formación profesional, aunque es un reto llevarla a la práctica de manera eficiente en las clases masivas. Para comparar el efecto de dos tipos de retroalimentación sobre el desempeño en la lectura estratégica se condujo una intervención instruccional con un diseño cuasiexperimental. Dos grupos focales de estudiantes de segundo semestre de licenciatura realizaron cuatro ejercicios con el Modelo de Análisis Estratégico de Textos (MAEtxt). Como retroalimentación a sus ejecuciones, uno de los grupos recibió por escrito un mensaje con los criterios de logro de la tarea, mientras el segundo grupo tomó tutorías personalizadas brindadas por seis estudiantes avanzados. Las respuestas al MAEtxt se recolectaron en línea y se calificaron mediante una rúbrica. Un ANOVA de medidas repetidas identificó diferencias entre los puntajes iniciales y finales de ambos grupos, y el análisis de frecuencias muestra que las tutorías promueven más respuestas de alta calidad. Los dos tipos de retroalimentación mostraron efectividad, por lo que se recomienda el uso de tutorías cuando sea posible, aunque la retroalimentación mediante definiciones de criterio puede ser valiosa si no hubiera recursos adicionales.

Palabras clave: educación superior, retroalimentación, prueba de lectura, método de alfabetización, tamaño de la clase

I. Introducción

De acuerdo con la estadística más reciente de la Asociación Nacional de Universidades e Instituciones de Educación Superior (ANUIES, 2022), en el último período escolar en México había 5,192,618 estudiantes matriculados en este nivel educativo, lo cual ha sido un aumento considerable a partir de la creación de nuevas universidades, la prevalencia de aulas masivas y la creación de carreras híbridas y en línea (Moreno, 2015). Para finales del 2021, cuando salió la más reciente edición de la Encuesta Nacional sobre Acceso y Permanencia en la Educación (ENAPE) la tasa bruta de cobertura se había ampliado a 34.7% (Secretaría de Educación Pública [SEP], 2021). Esta tasa, a pesar de que representa un avance, sigue siendo baja frente los estándares internacionales y plantea la necesidad de seguir haciendo esfuerzos para eliminar las barreras y garantizar el acceso universal a ese bien público que es la educación (Instituto Internacional de la Unesco para la Educación Superior en América Latina y el Caribe [IESALC], 2020). Sin embargo, para que realmente se cumpla la condición de equidad y el beneficio social derivado de la cobertura educativa, además de ampliar la cobertura es altamente relevante que todas las opciones ofertadas garanticen la calidad de sus funciones.

En el informe “Educación para todos: el imperativo de la calidad”, la Unesco (2004) define la calidad educativa como el logro de los aprendizajes esperados, así como la relevancia de dichos aprendizajes frente a las expectativas y necesidades de desarrollo, desempeño profesional y participación ciudadana de los individuos y de la sociedad en conjunto. El informe señala que el reto en las políticas públicas para la educación superior es la necesidad de ampliar y diversificar la oferta para que una mayor proporción de la población acceda a las oportunidades educativas, sin dejar de garantizar la calidad de la formación que se puede ofrecer en estos espacios, señalando con contundencia que la cantidad y la calidad de la educación no tendrían por qué ser intercambiables.

Esas buenas intenciones son claramente compartidas por los agentes involucrados en la educación: instancias de gobierno, escuelas, docentes, estudiantes, administración escolar, etc., pero la realidad es que una de las alternativas a las que se recurre para ampliar la matrícula (la programación de grupos masivos en las universidades) representa un reto significativo para la calidad educativa. Y es un reto que recae directamente en el ámbito de responsabilidad de los docentes.

Cuando se tienen grupos de 60 u 80 estudiantes, como en las universidades públicas mexicanas, o de 200 o 250, como en las universidades estadounidenses, hay una dificultad real para dar seguimiento al aprendizaje de tal diversidad de aprendices al mismo tiempo (Crouch y Mazur, 2001), tanto por la dificultad de interactuar directamente con cada persona como por la falta de tiempo para que los docentes puedan evaluar cientos de productos, como escritos y proyectos (Rimer, 2009). El alumnado se enfrenta al anonimato, a la falta de retroalimentación de sus avances y a la incertidumbre sobre lo que debería saber en comparación con sus pares (Carbone y Greenberg, 1998; Lawrence, 2022).

Todo ello contribuye a que la práctica docente predominante ante grupos masivos se convierta en la clase tipo conferencia, con docentes transmitiendo información y modelando procedimientos frente a estudiantes que escuchan, que tal vez toman notas, que tal vez leyeron la bibliografía básica del curso al menos superficialmente, y que tal vez se preparan para memorizar y replicar la información en los exámenes. Pero no necesariamente habrán reflexionado, organizado ideas, practicado alguna habilidad o expresado preguntas propias por razones que van desde el desinterés hasta la inseguridad (Montgomery et al., 2019). De hecho, es altamente probable que la distracción sea su actividad predominante (Deslauriers et al., 2019; Flanigan y Babchuk, 2022; McAndrew et al., 2018).

Exponer al alumnado a los discursos de su área en una clase tipo conferencia y pedirles que consulten textos especializados no es suficiente para hacerles participar en lo que Carlino (2005) denomina cultura discursiva de las disciplinas. Para convertirse en parte de un gremio, para realmente ser profesionales de un área, sería preciso que el alumnado desarrolle durante su formación: 1) la capacidad de analizar y producir textos propios con lenguaje especializado característico de una convención disciplinar, 2) la habilidad para contrastar y comparar explicaciones alternativas o complementarias, 3) la capacidad de identificar limitaciones en el proceso de argumentación o de investigación que respalda las afirmaciones o hallazgos, y 4) la habilidad para identificar debilidades en los planes de intervención o incoherencias entre los objetivos y las conclusiones, entre otras, además de mantener una evaluación continua de los procesos que permita actuar con flexibilidad y, en última instancia, cumplir con el mandato ético de una práctica profesional actualizada y en contacto con el desarrollo disciplinar. Esas son las competencias que las instancias internacionales esperan de quienes egresan de los niveles superiores (APA, 2013; World Economic Forum, 2023), pero difícilmente éstas se pueden “contagiar” a partir de escuchar a sus docentes desde el anonimato de un aula o auditorio lleno.

La brecha entre lo deseable y la realidad actual se hace evidente en las evaluaciones que demuestran que el alumnado de licenciatura cuenta con habilidades muy básicas para analizar una lectura (Amavizca y Álvarez-Flores, 2022; Guerra-García et al., 2022), que generalmente alcanzan para la realización de paráfrasis, síntesis y para redactar documentos con la información que recuperan de otros textos, reportando lo que quisieron decir las personas que los escribieron (Cepeda et al., 2020). Estas habilidades efectivamente permiten al alumnado familiarizarse con la información de su campo y recuperarla para realizar tareas o exámenes de manera eficiente (Molina et al., 2018), pero no serán suficientes para evaluar un problema o para tomar decisiones al respecto. Por ello es importante que además de participar en clases masivas, la educación superior promueva que los estudiantes realicen tareas que impliquen evaluación, generación de alternativas y toma de decisiones. Pero la dificultad que recae sobre los docentes es cómo guiar y retroalimentar la ejecución de la manera más efectiva posible para que más estudiantes logren los objetivos formativos.

Frente a estas necesidades formativas, en nuestro contexto se ha desarrollado la propuesta del Modelo de Análisis Estratégico de Textos o MAEtxt (Santoyo, 2021), que deriva de la premisa de que la revisión y análisis de textos, con una guía pertinente y retroalimentación efectiva, puede convertirse en una tarea que realmente ponga en juego las competencias que el medio profesional requerirá de los egresados, primero de manera supervisada y guiada, y cada vez con mayor autonomía y más parecido a los escenarios y problemas reales que deberán enfrentar.

El MAEtxt es una herramienta que consta de 16 tareas que guían al usuario para la identificación de elementos de un texto, para realizar inferencias, conexiones y juicios que permitan una comprensión profunda e induzcan la práctica de habilidades de evaluación y planeación en su área de interés. Cada pregunta hace referencia a una de 16 categorías que han mostrado ser formativamente útiles para aprehender activamente el conocimiento teórico y metodológico que se puede derivar de las lecturas, por ejemplo: identificar la unidad de análisis, inferir los supuestos básicos en los que se apoya el trabajo o generar cursos alternativos de acción. Típicamente, estos estudios se realizan en escenarios naturales, es decir, en las aulas universitarias, previo acuerdo con los participantes, mediante el uso de lecturas asociadas a los fines formativos de las asignaturas. Y se utiliza la evaluación y retroalimentación de sus desempeños iniciales para promover mejoras en ejercicios posteriores. Una vez concluido el curso, se realizan análisis grupales y tendencias del desempeño con el fin de sistematizar la evidencia de la utilidad del modelo.

La eficacia y la aceptación de quienes han utilizado el MAEtxt en diversos niveles educativos y diferentes instituciones han sido reportadas en estudios que pueden consultarse en la página del Laboratorio de Psicología de la UNAM (Laboratorio de Investigación sobre Desarrollo y Contexto del Comportamiento Social, 2021). Sin embargo, en algunos de ellos también se ha reportado gran variabilidad en los avances: perfiles de estudiantes que aprovechan más la experiencia y otros que casi no logran diferencias antes y después de las intervenciones; es probable que la guía y la retroalimentación resulta útil para algunas personas, pero no para todas.

Por esa razón, de manera reciente se han hecho esfuerzos para identificar los tipos de retroalimentación que podrían favorecer el mejor aprovechamiento de las estrategias instruccionales. Retomando la definición de Hattie y Timpperley (2007), la retroalimentación es aquella información que recibimos como consecuencia del desempeño ejecutado. Puede ser un indicador de qué tan completa o pertinente fue nuestra respuesta, o qué tanto nuestra conducta se acercó al criterio de logro. También podría incluir ideas alternativas que complementen nuestra respuesta, elementos que nos faltó contemplar, implicaciones adicionales, o incluso cuestionamientos que nos lleven a replantear, completar o explicar mejor nuestras posiciones. La retroalimentación efectiva, que generalmente se ubica como aquella que es inmediata, pertinente, objetiva y específica (Lam et al., 2022) permite a los docentes moldear y modificar conductas en el alumnado orientándolas hacia los objetivos formativos deseados (Archer, 2010), y al alumno le permite tomar decisiones autorreguladas sobre su propio comportamiento, al tener puntos de referencia claros sobre lo que se espera de su ejecución (Garello y Rinaudo, 2013) y brindar ideas más realistas sobre el propio desempeño, que de manera natural suele sobreestimarse (Agarwal y Bain, 2019). Así, la retroalimentación efectiva es una herramienta indispensable que puede generar grandes diferencias en el aprendizaje, para bien y para mal, en función tanto de la forma como del contenido que reciba quien está aprendiendo (Moreno y Ramírez, 2022; Sarkany y Deitte, 2017), sin embargo, es una de las tareas más complicadas en las clases masivas descritas anteriormente (Riches, 2017).

El contexto ideal para el uso del MAEtxt ha sido en grupos pequeños, en donde es posible observar directamente el desempeño de cada estudiante, retroalimentar de inmediato sus análisis, identificar sus debilidades y fortalezas y evaluar sus avances a lo largo del curso. Este es un ambiente en el que incluso se puede promover la retroalimentación por pares, que ha sido reportada como un factor positivo para el desempeño en general y para las habilidades de pensamiento crítico en específico (Ekahitanond, 2013). En este tipo de grupos, incluso una retroalimentación genérica, basada en recordatorios sobre la estructura esperada de la respuesta, ha mostrado ser tan efectiva como una retroalimentación muy específica y personalizada (Colmenares et al., 2022). En grupos masivos, en cambio, resulta muy complejo dar una retroalimentación tan detallada.

Sin embargo, la sistematización de la retroalimentación a grupos grandes es un reto necesario y prometedor. Por esa razón, en el contexto de estos esfuerzos educativos orientados a fortalecer los conocimientos metodológicos y las habilidades de análisis crítico y evaluación a partir de una serie de ejercicios de análisis estratégico de textos con el MAEtxt, se realizó una intervención educativa comparativa con el objetivo de evaluar la efectividad de dos estrategias de retroalimentación sobre el desempeño del alumnado. Por un lado, se diseñó una estrategia de retroalimentación ágil y práctica para implementar en clases masivas, que implicaba recordar la demanda de la tarea para brindar al alumnado un punto de referencia. Es decir, se les enviaba por escrito cuál era la definición de la categoría que debían responder en cada caso, lo cual constituiría una especie de “respuesta esperada” aunque es importante recordar que el MAEtxt no tiene respuestas correctas únicas, sino que espera que sus respondientes utilicen su propio vocabulario para expresar aquellos elementos del texto que corresponden a la definición. Esta estrategia se implementó en un grupo natural de segundo semestre. Por otro lado, se trabajó en la coordinación de un equipo de estudiantes del último semestre de la licenciatura, quienes cursaban la asignatura de Taller de investigación y docencia, para que fungieran como tutores y pudieran apoyar la retroalimentación individual del alumnado de otro grupo de segundo semestre, sosteniendo reuniones posteriores a cada ejercicio, en las cuales podían devolver los puntajes obtenidos, recordar los criterios de logro de cada categoría, y señalar la diferencia entre la ejecución y lo esperado.

II. Método

Participantes. Participaron dos grupos naturales de estudiantes de segundo semestre de licenciatura en Psicología de una universidad pública, quienes cursaban la asignatura de Introducción a la Metodología de la Investigación en Psicología. Ambos grupos eran de entre 50 y 60 estudiantes, pero se presentan los datos de aquellos que cumplieron con la mayor parte de las entregas. Del primer grupo, que recibió retroalimentación con la definición de la categoría de análisis, se incluyen datos de 39 estudiantes (34 mujeres y 5 hombres), que entregaron al menos cuatro de los seis ejercicios programados en el curso. Del segundo grupo, que recibió retroalimentación a través de tutorías individuales, se presentan datos de 23 estudiantes (16 mujeres y 7 hombres), quienes entregaron al menos tres de los cuatro ejercicios solicitados.

La intervención educativa fue guiada por el docente del grupo, y las tutorías individuales se impartieron por seis estudiantes de octavo semestre (dos hombres y cuatro mujeres), quienes recibieron entrenamiento en el MAEtxt y asesoría por parte de una estudiante de posgrado y una profesora adjunta.

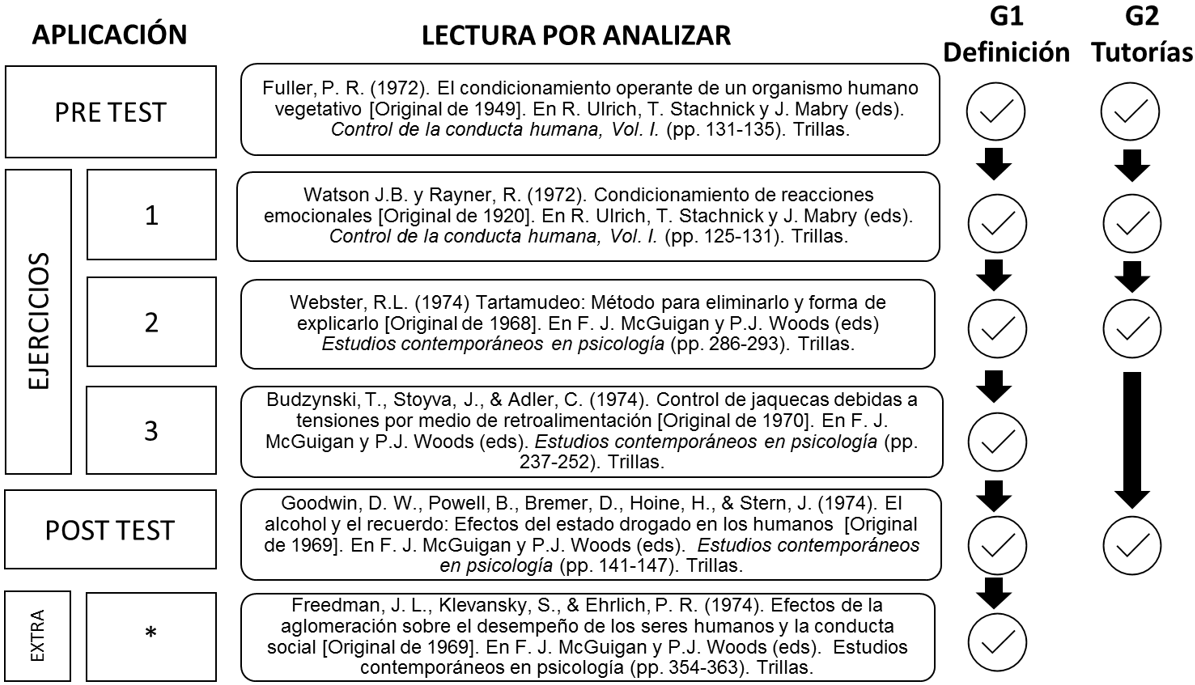

Instrumentos. Como material para los ejercicios de análisis se utilizó la traducción al español de seis artículos científicos publicados, pertinentes a los objetivos curriculares de la asignatura, en el orden que se muestra en la Figura 1. Por cuestiones de diseño, el grupo 1 revisó seis ejercicios, mientras que el grupo 2 analizó cuatro.

El instrumento central para los análisis fue el MAEtxt, incluyendo las preguntas que corresponden a sus 16 categorías. Todos los ejercicios se realizaron en línea mediante la plataforma de administración de aprendizaje Moodle®. Las tutorías se realizaron por videollamada a través de la plataforma Zoom®.

Cada una de las respuestas a las categorías del MAEtxt se calificó por parte de jueces entrenados en el uso de una rúbrica en la cual se califica con: 0 = Respuesta ausente, 1 = Respuesta incorrecta, 2 = Respuesta parcialmente correcta, y 3 = Respuesta que satisface el criterio de la categoría.

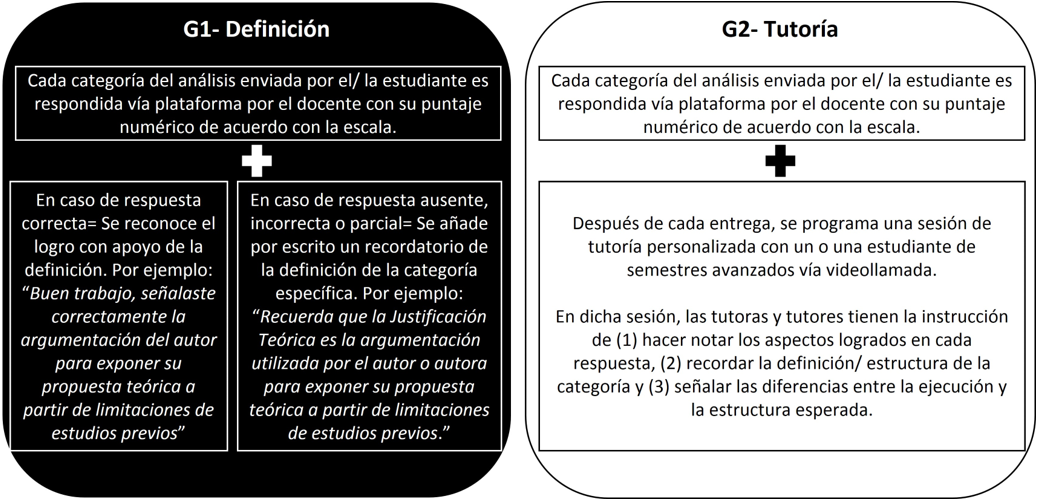

Diseño. Se aplicó un diseño cuasiexperimental con dos grupos y cuatro medidas de comparación: el Grupo 1 recibió retroalimentación a través de la definición de la categoría, mientras que el Grupo 2 lo hizo a través de tutorías individualizadas (Figura 2).

Procedimiento

Entrenamiento para tutorías. El grupo de estudiantes de 8.° semestre recibió instrucción sobre el manejo de categorías y protocolos de calificación del MAEtxt, y debía realizar por su cuenta los análisis de las mismas lecturas que retroalimentaría. Una vez que obtenían al menos 32 puntos en sus análisis y no tenían ningún puntaje de cero o uno (respuestas ausentes o incorrectas), se les brindaban ejercicios de prueba para que practicaran la calificación. Estos ejercicios eran evaluados en paralelo por una experta en el modelo (una profesora adjunta o una estudiante de doctorado), y se evaluaba la concordancia de calificaciones, repitiendo la práctica, la retroalimentación y la reflexión sobre la evaluación hasta que cada tutor alcanzaba una concordancia superior al 80% con las expertas. En ese momento, los estudiantes tutores se distribuyeron para evaluar y dar retroalimentación personalizada del grupo de estudiantes de 2.º semestre. Cada estudiante del equipo brindó tutorías en promedio a tres personas en cada uno de los cuatro ejercicios, siendo siempre diferentes las personas tutoradas en cada ejercicio.

La experiencia instruccional. Como parte de las asignaciones obligatorias de la clase, se solicitó al alumnado realizar ejercicios de lectura y análisis estratégico de textos a lo largo del semestre a través de la plataforma en línea. Los estudiantes del grupo recibían el ejercicio al mismo tiempo y encontraban en él: 1) la lectura, 2) las preguntas asociadas al MAEtxt, 3) el tiempo límite de entrega, que era de dos semanas, y 4) el espacio para responder. El grupo 1 recibió la retroalimentación (puntaje y definición de la categoría) a través de un comentario escrito en la misma plataforma, mientras que el grupo 2 utilizó, además del puntaje y recomendaciones por escrito recibidos en plataforma, una sesión de asesoría personal a través de videollamada con el tutor o tutora.

III. Resultados

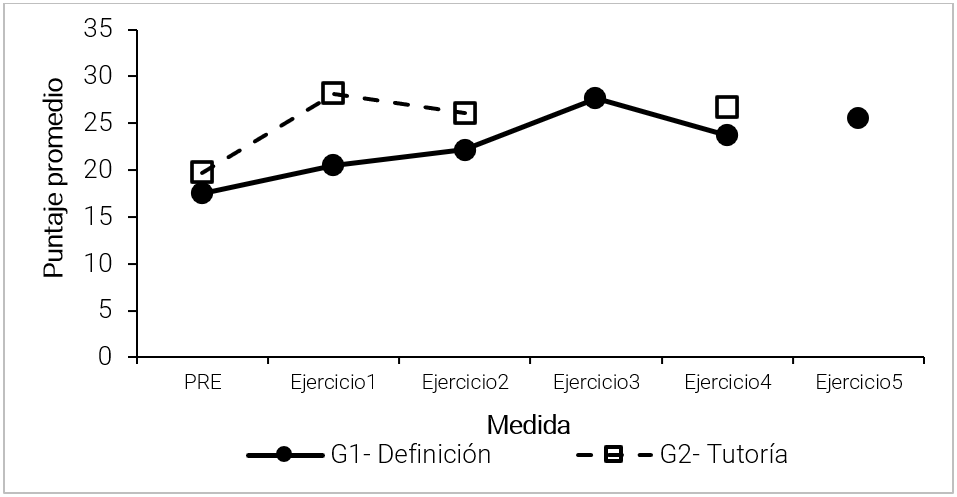

En la Figura 3 se muestran los puntajes promedio de cada uno de los grupos en cada ejercicio, que comienzan en el pretest con una diferencia muy pequeña. A partir del ejercicio 1, en donde ya recibieron su primera retroalimentación diferenciada, los grupos van aumentando sus puntajes progresivamente, lo cual indica que el desempeño va mejorando con la práctica. Sin embargo, se observa que el G2 mantiene puntajes ligeramente más altos en todos los ejercicios posteriores.

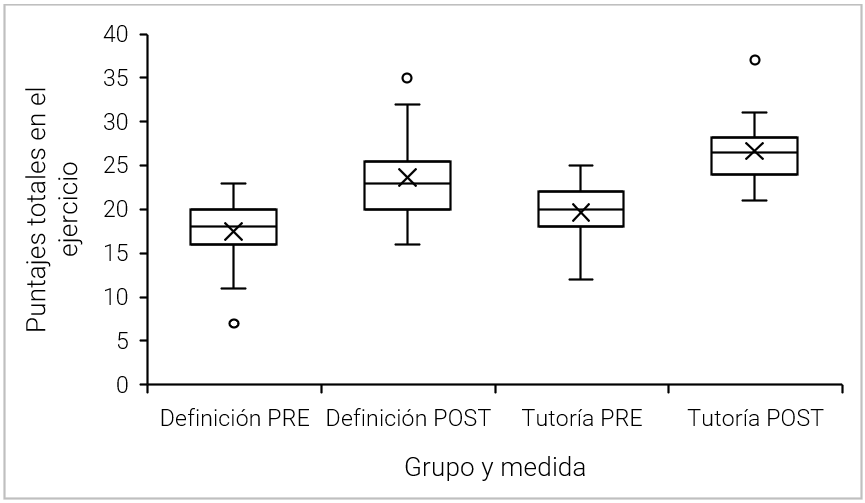

No obstante, la experiencia ha mostrado que existe variabilidad en el desempeño que los promedios podrían estar ocultando, por lo que se optó por comparar las distribuciones de los puntajes entre la medida inicial y la final mediante una prueba ANOVA de medidas repetidas y sus correspondientes valoraciones post hoc. Así, se evidenció una diferencia significativa entre los puntajes obtenidos en el pre y postest (F1,50 = 77.894; p < 0.001), así como diferencias entre los dos grupos por tipo de retroalimentación (F1,50 = 11.9; p = 0.001), aunque no se encontró ningún efecto de interacción entre las dos variables. En la Figura 4 se aprecia que las distribuciones en las dos medidas iniciales son semejantes al inicio (t = -2.57; p = 0.061), y que hay un cambio en la distribución para la medida final, tanto en el grupo 1 (t = -6.52; p < 0.001) como para el grupo 2 (t = -6.04; p < 0.001). Aunque no se identificó una diferencia significativa entre los puntajes finales de los dos grupos, la gráfica de la Figura 4 muestra que la distribución del puntaje final del grupo que recibió tutorías se orienta hacia valores más altos, y que no hay puntajes menores a 21 puntos, a diferencia del grupo de definiciones —cuyo valor mínimo es de 16.

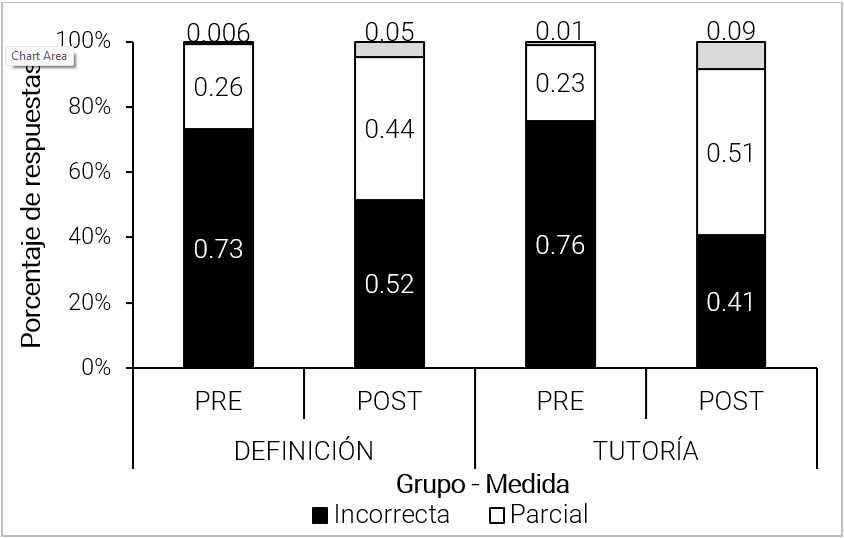

A nivel más molecular, se analizó si la experiencia con los dos tipos de retroalimentación produce una diferencia en la calidad de las respuestas del alumnado. Para ello, se calculó el porcentaje de respuestas ausentes o incorrectas que presentó el grupo en conjunto en la primera y en la última medición, así como la proporción de respuestas parcialmente correctas y correctas. Como se muestra en la Figura 5, en las medidas iniciales la mayor parte de las respuestas eran incorrectas o estaban en blanco, mientras que en las medidas finales de ambos grupos aumenta significativamente el margen de respuestas parcialmente correctas y correctas, siendo ligeramente más efectiva la intervención para el grupo de tutoría.

IV. Discusión y conclusiones

Los grupos masivos en las aulas universitarias son un reto para la docencia, pero representan una realidad ineludible, por lo que todos los esfuerzos para sistematizar las experiencias y documentar las estrategias que la evidencia identifica como buenas prácticas serán valiosos. El presente estudio se realizó en el contexto de grupos grandes, en una asignatura en la que de por sí suele ser complicado involucrar activamente al alumnado (Espinoza y Petrović, 2021), con el objetivo de generar evidencia sobre la eficacia de dos estrategias con diferentes ventajas didácticas, sobre la ejecución en una serie de ejercicios de análisis estratégico de literatura con apoyo del MAEtxt. Por un lado, una estrategia ágil y con bajos costos de implementación, como sería la retroalimentación individual con recordatorios de los criterios de logro (la definición) y un indicador de la aproximación lograda por el estudiante (el puntaje). Por otro lado, una estrategia de alto costo, pero con mayores elementos para informar al alumnado sobre su desempeño y los pasos que podría tomar para alcanzar niveles más altos de logro, como fueron las tutorías individualizadas.

La primera lección del presente estudio tiene que ver con la muestra, pues a pesar de ser grupos grandes, no fue posible incorporar a todo el grupo al análisis porque no todo mundo siguió el paso de la intervención, y tuvimos muchos casos de estudiantes que omitían la entrega de los ejercicios. Este fenómeno posiblemente deriva de las dificultades que ya se han documentado para mantener la motivación, la atención y la participación activa en grupos grandes. Pero definitivamente es un problema adicional, pues no es posible retroalimentar la nula ejecución y estamos frente a una proporción del grupo que no accederá a los posibles beneficios de las actividades de aprendizaje, incluso cuando esto tenga repercusiones sobre sus calificaciones. Será necesario encontrar estrategias adicionales que eliminen esas barreras iniciales para la participación que tal vez no están generando un abandono de las clases, pero sí un rezago en términos reales.

En cuanto a las personas que sí participaron en la experiencia instruccional, se identificó que ambas estrategias generaron un avance en el desempeño con el MAEtxt, lo cual es consistente con la evidencia previa de la utilidad y efectividad del modelo como una herramienta para ejercitar el análisis, la toma de decisiones y en general el manejo crítico de la información que típicamente se lee en las clases de nivel licenciatura. La evidencia muestra que la herramienta produce avances en diferentes niveles educativos, asignaturas y contextos, aunque justamente se ha documentado que en los niveles iniciales como en el que se ubicó la presente investigación, el alumnado no tiene resultados óptimos porque presenta dificultades para tareas como identificar los supuestos básicos de un texto o evaluar la coherencia externa (Santoyo 2021). Se ha sugerido que esto posiblemente está asociado al conocimiento incipiente sobre el campo de conocimiento con el que cuentan en ese momento de su desarrollo académico (Colmenares et al., 2022), lo cual tiene sentido considerando que la ejecución en el MAEtxt no tiene una forma única de responderse correctamente, pues existe un proceso de cambio y crecimiento académico y profesional que permitirá a la persona usuaria completar y profundizar sus análisis incluso sobre un mismo texto, conforme tenga más conocimientos teóricos y mejores habilidades metodológicas. Por esa misma razón, también es posible que el alumnado de diferentes niveles pueda aprovechar de maneras diferenciales diferentes tipos de retroalimentación, para lo cual será relevante continuar con esta línea de investigación.

Las lecturas que se utilizan como material para los ejercicios difieren en extensión, estilo argumentativo, etc. porque son seleccionadas por la pertinencia de su contenido para los objetivos de la clase, y no por aspectos formales. Por ello, es de esperarse que los avances en los análisis no sean siempre de la misma magnitud entre un ejercicio y el siguiente, e incluso que en algunos casos haya aparentes retrocesos. Sin embargo, lejos de ser una limitación, esto implica asumir que los profesionales que egresan de la formación en licenciatura afrontarán una realidad que no siempre es lineal u homogénea, y es esa realidad la que les corresponderá explicar y sobre la cual les corresponde proponer alternativas desde la evidencia sistemática. En ese sentido, la sensibilidad del alumnado ante las diferencias entre los textos y el avance acumulado a lo largo de las intervenciones es evidencia también de la validez ecológica del modelo, que demuestra su aplicabilidad frente a diferentes tipos de textos y de contenidos.

En las comparaciones del desempeño final contra el diagnóstico inicial, se observan ganancias ligeramente mayores con la estrategia de tutorías, así como una mejor calidad en las respuestas y argumentos que brindó el alumnado de este grupo en su ejercicio final del semestre. A partir de lo que sugiere este hallazgo, una prospectiva interesante podría encaminarse a realizar un análisis más fino con respecto a la calidad de las respuestas, desagregando cada una de las tareas para valorar si es posible detectar mayores avances en algunas de ellas o dificultades específicas en otras, y si es posible identificar diferencias entre los grupos a ese nivel. Esto permitiría profundizar en la delimitación de posibles necesidades específicas de retroalimentación por tareas y por categorías de análisis, lo cual podría redituar en estrategias aún más efectivas.

La ventaja del grupo que recibió tutorías sugiere que la inversión de tiempo en el entrenamiento del grupo de estudiantes avanzados, y el trabajo que este equipo realizó a lo largo de todo un semestre, tiene buenos frutos. El apoyo tutoral fortalece el involucramiento del alumnado del grupo masivo, permite una interacción más efectiva y un apoyo más directo a sus procesos de aprendizaje. Pero también implica ventajas para los estudiantes tutores, quienes se formaron en el manejo en el MAEtxt y experimentaron sus propios procesos de práctica, retroalimentación y avance progresivo con ayuda de las coordinadoras del equipo, lo cual representó un aprendizaje práctico con criterios de logro mucho más estrictos que los que se aplicaron al alumnado novato. Este equipo también ejercitó habilidades de evaluación, intervención y análisis de procesos de manera muy activa, al calificar los ejercicios recibidos, planificar y brindar las tutorías. Sería deseable que estas experiencias estuvieran al alcance del alumnado avanzado de la licenciatura, porque les brinda un contexto que promueve la práctica de tareas como el uso de herramientas de medición y evaluación, la interacción efectiva con aprendices, la planeación de una intervención, y la valoración de su propia ejecución como tutores para ajustar su comportamiento en las siguientes experiencias. Todo ello, en una situación supervisada y acompañada por profesionales de mayor experiencia. En este sentido, para los estudiantes avanzados representa un ejercicio práctico de competencias generalizables al ámbito profesional en el que deben insertarse próximamente.

La retroalimentación por definición de las categorías también tuvo cierta efectividad para mejorar el desempeño en el análisis estratégico. Es posible que existan formas de mejorar o diversificar esta retroalimentación ágil y directa de manera que sea posible promover la participación del alumnado en los ejercicios incluso en los casos en los que al docente responsable del grupo masivo le es imposible contar con ayuda de tutores adicionales. Otra opción que se ha explorado para esta retroalimentación rápida y general a grupos grandes ha sido el brindar información sobre la estructura esperada para cada categoría (Colmenares et al., 2022), lo cual ha arrojado resultados prometedores en alumnado de los últimos semestres, pero deberá ponerse a prueba bajo otros contextos.

Las Tecnologías de la Información y las Comunicaciones (TIC), para el aprendizaje y el conocimiento (TAC) y para el empoderamiento y la participación (TEP), han hecho posible la masificación de los conocimientos, con clases híbridas o cursos autoadministrados en línea que no requieren un espacio físico o un horario en donde quepan todas las personas involucradas (Orozco et al., 2020). También han generado herramientas que han demostrado mejorar el desempeño, la motivación por los contenidos y el involucramiento en las actividades de aprendizaje tanto en línea como presencial, como la inteligencia artificial, el llamado machine learning, los mediadores virtuales, etc. (Tautz et al., 2021; Wambsganss et al., 2022; Yang et al., 2018). Sin embargo, es importante recordar que más allá del medio, lo que realizan estas herramientas es lo que ha mostrado la investigación en Psicología que tiene efectividad como retroalimentación: el señalar el resultado obtenido (por ejemplo, identificaste bien la unidad de análisis), recordar el criterio del logro (recuerda que se trata de hacer un juicio sobre la coherencia interna del texto), y brindar puntos de referencia, ya sea con respecto al criterio (tienes 8 de 10 aciertos posibles) como con respecto a otros aprendices (el promedio del grupo es de 28 puntos). Posiblemente la tecnología puede ayudar a hacer esta retroalimentación de manera más ágil y menos costosa, pero seguirá siendo necesaria la investigación educativa que alimente y dé contenido a lo que las herramientas pueden realizar.

Agradecimiento

Los autores agradecen el apoyo a Elizabeth Norma Ortega Maldonado, coordinadora y entrenadora de tutores, y a los estudiantes tutores: Ángel Olaf Guzmán Álvarez, Edith Trejo Centeno, Elsa Itzel Ramírez López, Fernando Raymundo Bazán Vargas, Lirba Zeltzin García Cardona y Patricia Sarai Espinoza Bernal.

Contribución de autoría

Ligia Colmenares Vázquez: conceptualización (60%), investigación (70%), metodología (50%), análisis formal, redacción de borrador original (50%), redacción: revisión y edición.

Guadalupe Yamilet Torres López: curación de datos, metodología (50%), redacción de borrador original (50%).

Carlos Santoyo: conceptualización (40%), investigación (30%), supervisión, administración de proyecto.

Declaración de no conflicto de intereses

Los autores declaran no tener conflicto de intereses.

Fuente de financiamiento

La investigación no ha contado con financiamiento.

Referencias

Agarwal, P. K. y Bain, P. M. (2019). Engage students with feedback-driven metacognition. En P. K. Agarwal y P. M. Bain (Eds.). Powerful teaching: Unleash the science of learning (pp. 123-152). Wiley. https://doi.org/10.1002/9781119549031

Amavizca, S. y Álvarez-Flores, E. P. (2022). Comprensión lectora en universitarios: comparativo por áreas de conocimiento. Revista Electrónica de Investigación Educativa, 24(e20), 1–13. https://doi.org/10.24320/redie.2022.24.e20.3986

Archer, J. C. (2010). State of the science in health professional education: Effective feedback. Medical Education, 44(1),101–108. https://doi.org/10.1111/j.1365-2923.2009.03546.x

Asociación Nacional de Universidades e Instituciones de Educación Superior (2022). Anuario estadístico de la población escolar en Educación superior. Ciclo escolar 2022-2023. http://www.anuies.mx/gestor/data/personal/anuies05/anuario/Anuario_Educacion_Superior_2022-2023.zip

American Psychological Association (2013). APA Guidelines for the undergraduate psychology major Version 2.0 https://www.apa.org/ed/precollege/about/psymajor-guidelines.pdf

Carbone, E. y Greenberg, J. (1998). Teaching large classes: Unpacking the problem and responding creatively. To Improve the Academy: A Journal of Educational Development, (399). https://digitalcommons.unl.edu/podimproveacad/399

Carlino, P. (2005). Escribir, leer y aprender en la universidad. Una introducción a la alfabetización académica. Fondo de Cultura Económica.

Cepeda, M. L., Hickman, H., Ramírez, J. J. B., Zavaleta, R. y Ruíz, D. (2020). Caracterización de la paráfrasis en estudiantes universitarios. Revista Digital Internacional de Psicología Y Ciencia Social, 6(2), 302–317. https://doi.org/10.22402/j.rdipycs.unam.6.2.2020.264.302-317

Colmenares, L., Torres, G. Y. y Santoyo, C. (2022). The role of feedback in decision making learning in Psychology: Critical thinking and flexibility. Journal of Technical Education, 6(17), 20–31. https://www.ecorfan.org/republicofperu/research_journals/Revista_de_Educacion_Tecnica/vol6num17/Journal_of_Technical_Education_V6_N17_3.pdf

Crouch, C. H. y Mazur, E. (2001). Peer Instruction: Ten years of experience and results. American Journal of Physics, 69(9), 970-977. https://doi.org/10.1119/1.1374249

Deslauriers, L., McCarty, L. S., Miller, K., Callaghan, K. y Kestin, G. (2019). Measuring actual learning versus feeling of learning in response to being actively engaged in the classroom. Proceedings of the National Academy of Sciences, 116(39) 19251–19257. https://doi.org/10.1073/pnas.1821936116

Ekahitanond, V. (2013). Promoting university students’ critical thinking skills through peer feedback activity in an online discussion forum. Alberta Journal of Educational Research, 59(2), 247–265.

Espinoza, E. E. y Petrović, B. K. (2021). Percepción de los estudiantes sobre la enseñanza de la metodología de la investigación científica. Universidad y Sociedad, 13(6), 331–343. https://rus.ucf.edu.cu/index.php/rus/article/view/2397

Flanigan, A. E. y Babchuk, W. A. (2022). Digital distraction in the classroom: Exploring instructor perceptions and reactions. Teaching in Higher Education, 27(3), 352–370. https://doi.org/10.1080/13562517.2020.1724937

Garello, M. V. y Rinaudo, M. C. (2013). Autorregulación del aprendizaje, feedback y transferencia de conocimiento. Investigación de diseño con estudiantes universitarios. Revista Electrónica de Investigación Educativa, 15(2), 131–147. https://redie.uabc.mx/redie/article/view/451

Guerra-García, J., Díaz-Rubio, Z. I., Guevara-Benítez, C. Y. y Corona-Guevara, A. (2022). Evaluación de la comprensión lectora en alumnos universitarios mexicanos de matemáticas aplicadas y computación. Papeles, 14(28). https://doi.org/10.54104/papeles.v14n28.1271

Hattie, J. y Timperley, H. (2007). The power of feedback. Review of Educational Research, 77(1), 81-112. https://doi.org/10.3102/003465430298487

Instituto Internacional de la Unesco para la Educación Superior en América Latina y el Caribe. (2020). Hacia el acceso universal a la educación superior: tendencias internacionales. Biblioteca Digital Unesco. https://unesdoc.unesco.org/ark:/48223/pf0000375683

Laboratorio de Investigación sobre Desarrollo y Contexto del Comportamiento Social (2021). Análisis de la adquisición y enseñanza de Habilidades Metodológicas y Conceptuales. UNAM. http://www.comportamientosocial.psicol.unam.mx/aadq_pub.html

Lam, D. L., Sarkany, D. S., Whitman, G. J. y Straus, C. M. (2022). It's a two-way street: Giving and receiving feedback to the unaware. Current Problems in Diagnostic Radiology 51(1), 17–20. https://doi.org/10.1067/j.cpradiol.2021.06.004

Lawrence, J. E. (2022). Teaching large classes in higher education: Challenges and Strategies. The Educational Review, 6(6), 251–262. https://www.hillpublisher.com/ArticleDetails/998

McAndrew, A., Dykeman, T., Fell, C. y Nussbaum, B. (2018, October 25). Unpacking the student experience in large lectures. Educause Review. https://er.educause.edu/blogs/2018/10/unpacking-the-student-experience-in-large-lectures

Molina, R., Ríos, A. M. y Rivera, C. S. (2018). La paráfrasis textual como estrategia cognitiva para la comprensión lectora. Estudio realizado en los grados quinto y séptimo de tres instituciones educativas públicas de Yopal, Casanare. [Tesis de Maestría]. Universidad de La Salle, Facultad de Ciencias de la Educación, Colombia. https://ciencia.lasalle.edu.co/items/e7cee29c-a0eb-42a2-b7f7-964ebbce19d6

Montgomery, Ll., Evans, G., Harrison, F. y Damian, D. (2019). Towards a live anonymous question queue to address student apprehension. ArXiv, 1901. https://doi.org/10.48550/arXiv.1901.01061

Moreno, M. (2015). La educación superior a distancia en México: una propuesta para su análisis histórico. En J. Zubieta y C. Rama (Coords.). La educación a distancia en México: una nueva realidad universitaria (pp. 3–16). UNAM / Virtual Educa. https://cuaed.unam.mx/publicaciones/libro-evaluacion/pdf/Capitulo-04-EVALUACION-FORMATIVA-Y-RETROALIMENTACION.pdf

Moreno, T. y Ramírez, A. (2022). Evaluación formativa y retroalimentación del aprendizaje. En M. Sánchez y A. Martínez (Eds.). Evaluación y aprendizaje en educación universitaria: estrategias e instrumentos (pp. 65–79), UNAM/ CUAIEED. https://cuaieed.unam.mx/publicaciones/libro-evaluacion/

Orozco, G. H., Humanante, P. R. y Jiménez, C. N. (2020). Evolución e importancia de los MOOC en los procesos de formación académica: una revisión sistemática de la literatura. Espacios, 41(11), 12–16. https://revistaespacios.com/a20v41n11/a20v41n11p12.pdf

Riches, A. (2017, noviembre 22). In-class marking and feedback. Sec-Ed, The voice of Secondary Education. https://www.sec-ed.co.uk/best-practice/in-class-marking-and-feedback/

Rimer, S. (2009, enero 13). At M.I.T., large lectures are going the way of the blackboard. New York Times. http://www.nytimes.com/2009/01/13/us/13physics.html

Santoyo C. (2021). Tres décadas del modelo de evaluación, intervención y análisis de procesos: valoración y prospectiva. En C. Santoyo y L. Colmenares (Coords.), Patrones de habilidades metodológicas y conceptuales de análisis, planeación, evaluación e intervención en Ciencias del Comportamiento (pp. 145–166). UNAM/PAPIIT.

Sarkany, D. y Deitte, L. (2017). Providing feedback: Practical skills and strategies. Academic Radiology, 24(6), 740-746. https://doi.org/10.1016/j.acra.2016.11.023

Secretaría de Educación Pública. (SEP). (2021). Principales cifras del sistema educativo nacional 2020–2021. https://www.planeacion.sep.gob.mx/Doc/estadistica_e_indicadores/principales_cifras/principales_cifras_2020_2021_bolsillo.pdf

Tautz, D., Sprenger, D. A. y Schwaninger, A. (2021). Evaluation of four digital tools and their perceived impact on active learning, repetition and feedback in a large university class. Computers & Education, 175(104338). https://doi.org/10.1016/j.compedu.2021.104338

Unesco. (2004). Educación para todos: el imperativo de la calidad; Informe de seguimiento de la EPT en el mundo, 2005. https://unesdoc.unesco.org/ark:/48223/pf0000150169

Wambsganss, T., Janson, A. y Leimeister, J. M. (2022). Enhancing argumentative writing with automated feedback and social comparison nudging. Computers & Education, 191(104644). https://doi.org/10.1016/j.compedu.2022.104644

World Economic Forum. (2023). Future of jobs, Report 2023. https://www3.weforum.org/docs/WEF_Future_of_Jobs_2023.pdf

Yang, N., Ghislandi, P. y Dellantonio, S. (2018). Online collaboration in a large university class supports quality teaching. Educational Technology Research and Development, 66, 671–691. http://dx.doi.org/10.1007/s11423-017-9564-8