Revista Electrónica de Investigación Educativa

Vol. 17, Núm. 3, 2015

Validación

de constructo de un cuestionario de evaluación

de la competencia docente

Edna Luna Serrano

(*) eluna@uabc.edu.mx

Érika Paola Reyes Piñuelas (*) erikareyes@uabc.edu.mx

* Universidad Autónoma de Baja California

(Recibido: 16 de febrero de 2015; Aceptado para su publicación: 28 de abril de 2015)

Resumen

Este trabajo analiza la estructura interna del Cuestionario de Evaluación de la Competencia Docente, producto de un riguroso proceso metodológico de acumulación de evidencias de validez y confiabilidad. El cuestionario se fundamenta en el Modelo de Evaluación de Competencias Docentes (MECD). Se replicaron los análisis de unidimensionalidad (n=128,791) y AFE (n=67,111), como resultado se demostró que 32 reactivos evalúan el mismo constructo, la estructura interna reveló dos factores: planeación y gestión del proceso enseñanza-aprendizaje y conducción y valoración del proceso enseñanza-aprendizaje; una varianza total de 75.02% y alpha de Cronbach de .98. La estructura se comprobó con modelamiento de ecuaciones estructurales (n=462), donde resultó un RMSEA=.07, SRMR=.02, CFI y TLI=93. Se concluye que el cuestionario integra los componentes de la competencia docente significativos para los estudiantes y se demuestra su representatividad con las dimensiones del MECD.

Palabras clave: Evaluación de la docencia, enseñanza universitaria, cuestionario para alumnos, competencia profesional, elaboración de pruebas.

I. Introducción

La evaluación de la docencia se reconoce como una práctica social con implicaciones para la sociedad, las instituciones y los individuos. Constituye un recurso eficaz para la mejora de los procesos educativos, en la medida en que se utilice para reflexionar sobre las características consideradas esenciales en los procesos de enseñar y aprender (RIIED, 2008).

La evaluación docente con base en los puntajes de opinión de los estudiantes es la estrategia de evaluación más utilizada en Norteamérica, Europa y Asia, y al mismo tiempo, es la más estudiada (Rueda, Luna, García y Loredo, 2011; Seldin, 1993; Theall y Franklin, 2000). Los principales propósitos asociados a su utilización se relacionan con medidas de la efectividad de la enseñanza en la toma de decisiones administrativas, con el diagnóstico y retroalimentación de los maestros para mejorar el proceso de instrucción, y con la investigación sobre la enseñanza (Marsh, 2007). Por ello, se considera que los puntajes son útiles para los docentes, los estudiantes y los administradores.

Por tradición, los cuestionarios se han diseñado con base en los componentes que los expertos consideran más importantes para la enseñanza susceptibles a la observación y juicio de los estudiantes (Centra, 1993). Sin embargo, desde principios de los años noventa se habla de las limitaciones de incluir únicamente las dimensiones asociadas a la efectividad docente en los cuestionarios y la necesidad de incorporar los cambios contextuales propios de cada situación educativa, por ejemplo, las nuevas prácticas instruccionales derivadas de los planes de estudio por competencias, aprendizaje colaborativo, y la educación a distancia.

Cabe tener presente que todo instrumento de evaluación tiende a orientar la actividad objeto de valoración, en el caso particular de los cuestionarios de apreciación estudiantil responden de manera implícita al cuestionamiento sobre qué es un buen profesor y qué funciones debe realizar. Por tal motivo, incorporar las particularidades del contexto pedagógico es una manera de considerar la filosofía y misión de la institución (García-Cabrero, Loredo, Luna y Rueda, 2014; Theall y Franklin, 2000). De esta forma, se espera congruencia entre el instrumento de evaluación y el modelo de enseñanza que sustenta a la práctica docente.

Este artículo reporta los hallazgos obtenidos en el proceso de acumulación de evidencias de validez y confiabilidad del Cuestionario de Evaluación de la Competencia Docente (CECD) a partir de una muestra representativa de estudiantes de la Universidad Autónoma de Baja California (UABC), México. Dado que el marco teórico que sustentó el desarrollo del cuestionario son los principios del enfoque de enseñanza por competencias, se analizó la estructura interna producto del análisis factorial de corte exploratorio y confirmatorio a la luz de las dimensiones de la enseñanza por competencias.

II. Desarrollo

La teoría sobre la enseñanza que sustenta a la mayoría de los cuestionarios de evaluación docente por los alumnos considera que la enseñanza efectiva es multidimensional, por lo que se proponen evaluar las diferentes dimensiones que la conforman (Marsh, 2007). Además, el estudio de las dimensiones relacionadas con la efectividad docente las identifica y clasifica de acuerdo con su importancia para el aprendizaje. Así, se ubican como las más importantes: claridad y entendimiento; estimulación del interés por la materia; preparación y organización del curso; logro de los objetivos planteados; motivación a los estudiantes para tener alto rendimiento; y percepción del impacto de la enseñanza en el alumno. Las dimensiones de poca o ninguna importancia fueron: naturaleza y valor del curso; calidad y frecuencia de la realimentación del profesor al alumno; naturaleza y utilidad de los materiales didácticos y de apoyo; contenido y carga de trabajo; y dificultad del curso (Feldman, 1997). Donde el supuesto aceptado de manera generalizada es que las dimensiones de la enseñanza efectiva y los reactivos que las incluyen forman parte de las habilidades genéricas que todo docente debe presentar.

Además, la teoría clásica sobre el desarrollo de este tipo de cuestionarios propone combinar tres estrategias: 1) deducir los reactivos de un análisis lógico de los componentes de la efectividad docente, tomando en cuenta la retroalimentación de los profesores y estudiantes, así como los propósitos de la evaluación; 2) realizar análisis empíricos mediante el empleo de técnicas estadísticas como análisis factorial, diseños multirrasgo-multimétodo y modelamiento de ecuaciones estructurales; y 3) fundamentar los instrumentos de evaluación en una teoría de la enseñanza y aprendizaje (Marsh y Dunkin, 1997). No obstante, la mayoría de los cuestionarios desarrollados y publicados atienden los primeros dos aspectos e ignoran elementos centrales de la teoría del aprendizaje que les subyace (Luna, 2000).

Al mismo tiempo, se plantea la necesidad de incorporar los cambios contextuales propios de cada situación educativa, en particular las nuevas prácticas instruccionales derivadas de los planes de estudio por competencias, aprendizaje colaborativo y la educación a distancia (García-Cabrero, Loredo, Luna y Rueda, 2008; Theall y Franklin, 2000). En este sentido, se reconoce que al incorporar la aproximación de enseñanza por competencias en los programas de estudio conlleva una concepción de aprendizaje que demanda de la práctica docente características propias del enfoque que deben reflejarse en el contenido de las dimensiones y reactivos de los cuestionarios.

2.1 Fundamentos del Cuestionario de Evaluación de la Competencia Docente

La base teórica del CECD es el Modelo de Evaluación de Competencias Docentes para la Educación Media y Superior [MECD] (García-Cabrero et al., 2008). El MECD se desarrolló desde una aproximación constructivista, sociocultural y situada de las competencias; cuyo propósito es:

Orientar las actividades de profesores y directivos en los procesos de evaluación, con la intención de resaltar la importancia de la función docente y contribuir para que la evaluación repercuta principalmente en mejores prácticas para la enseñanza y el aprendizaje; además de coadyuvar a la implementación de procesos de evaluación justos y pertinentes (García-Cabrero et al., 2008, p. 98)

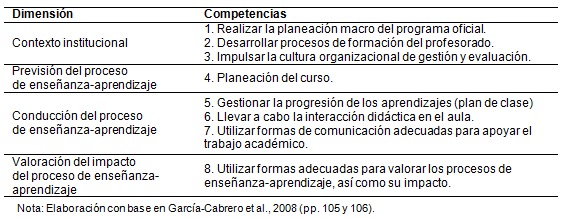

El MECD incluye cuatro dimensiones de análisis: 1) contexto institucional, 2) previsión del proceso de enseñanza-aprendizaje, 3) conducción del proceso del proceso enseñanza-aprendizaje y 4) valoración del impacto del proceso enseñanza-aprendizaje. Las cuales contienen ocho competencias (ver tabla I). Contexto institucional alude a las características particulares del contexto donde se desarrolla la actividad docente. Previsión del proceso de enseñanza-aprendizaje considera las teorías asumidas del profesor, entendidas como sus creencias y conocimientos sobre la enseñanza en general y en particular sobre su asignatura y sus expectativas sobre la enseñanza. Conducción del proceso enseñanza-aprendizaje incluye las teorías en uso vinculadas con la situación didáctica, la implementación de los diversos aspectos incluidos en la previsión del proceso, así como los mecanismos de interacción que operan en el aula, como son la naturaleza del grupo. Valoración del impacto del proceso de enseñanza-aprendizaje considera utilizar formas adecuadas para juzgar el proceso de enseñanza-aprendizaje y su impacto en el aprendizaje de los estudiantes (García-Cabrero et al., 2014).

Tabla I. Dimensiones y competencias del MECDM

El MECD retoma perspectivas sobre la competencia docente de autores como Cano, (2008); Perrenoud, (2004) y Zabalza (2005). Así, asume que las competencias implican la utilización de diversos recursos culturales, cognitivos, psicomotores y afectivos en contextos y situaciones específicas. Además, responde a principios particulares de evaluación de la docencia como: promover una evaluación formativa, participativa, humanista; con un enfoque multidimensional, multireferencial y contextualizado (García-Cabrero et al., 2014).

El MECD propone de manera implícita que las competencias pueden ser evaluadas a través de la explicitación de criterios y la medición de sus indicadores de manera separada. En este sentido, se adhiere a los planteamientos de Denyer, Furnemont, Poulain y Vanloubbeeck (2007), quienes consideran que las competencias pueden ser desglosadas para su evaluación. Para ello se requiere que los criterios sean pertinentes (medir los componentes esenciales de la tarea o familia de tareas), independientes (el éxito o fracaso de un criterio no conlleva al éxito o fracaso de otro), poco numerosos y jerarquizados (identificar los mínimos cuyo cumplimiento equivale al mínimo de la competencia, especificar criterios de perfeccionamiento útiles para determinar el nivel de excelencia). Esta aproximación a la evaluación de las competencias es diferente a la perspectiva integradora y global de las competencias, que postula que sólo es posible evaluarlas en contextos auténticos y de forma globalizada.

En la lógica del MECD es factible evaluar aspectos específicos y observables de la actividad docente. Las competencias son evaluadas por medio de tareas específicas determinadas a través de indicadores (observables y cuantificables) que miden el nivel de dominio alcanzado de determinada competencia.

Con base en el MECD se han desarrollado diferentes instrumentos de evaluación de la competencia docente, uno de ellos es el CECD y con el fin de abonar a la validez de constructo del mismo, el objetivo de este trabajo es confirmar las propiedades psicométricas del CECD en una muestra de estudiantes de la UABC en cuanto a su unidimensionalidad, estructura factorial y consistencia interna. De esta manera respondería a las preguntas: ¿El CECD se ajusta al MECD? ¿Se confirma la estructura factorial del CECD en la población de la UABC?

III. Método

El trabajo de investigación se realizó en dos etapas: la Etapa 1 corresponde a la obtención inicial de evidencias de validez y confiabilidad del instrumento; y en la Etapa 2 el interés se centró en confirmar si el MECD que subyace al cuestionario se ajusta a los datos de la muestra universitaria.

Participantes. Los puntajes analizados involucran a 37,094 estudiantes de licenciatura (representan el 77.3% de la población) que se encontraban inscritos en el primer periodo del 2011 en uno de los tres campus de la UABC. El 53.7% son de sexo femenino y el 43.3% del masculino, el rango de edad fluctúa de 17 años en adelante con una media aritmética de 20 años. Los puntajes se obtuvieron a través del portal en internet del Sistema de Evaluación Docente a partir del cual los estudiantes contestan el CECD, uno por asignatura cursada.

En la Etapa 1 se procesaron los puntajes de 199,967 cuestionarios que constituyen la muestra utilizada en el análisis de unidimensionalidad inicial, se decidió excluir los cuestionarios contestados con varianza cero para los subsecuentes procedimientos y en el análisis de unidimensionalidad final la muestra fue de 128,791. Se utilizó el método de validación cruzada con lo cual se obtuvieron dos muestras aleatorias: una para el Análisis Factorial Exploratorio (AFE) con 66,148 cuestionarios; y otra utilizada en la Etapa 2, para Análisis Factorial Confirmatorio (AFC) con 67,111 cuestionarios.

Instrumentos. Para la recolección de datos se utilizó el CECD con base en la opinión de los alumnos, el cual se desarrolló a partir de los componentes relevantes del MECD para la Educación Media y Superior. El cuestionario consta de 35 reactivos tipo Likert con cinco niveles de respuesta, que van de 1 (nunca) a 5 (siempre).

Los resultados relativos al desarrollo y validación del CECD que le anteceden fueron reportados por Luna, Calderón, Caso y Cordero (2012), entre los que destacan la estructura del cuestionario conformada por los factores Planeación y gestión, Interacción didáctica en el aula, Evaluación y comunicación del proceso enseñanza-aprendizaje y Tecnologías de la información y la comunicación, explicando el 59.3% de la varianza, índice de consistencia interna de .96, así como índices de ajuste aceptables que sugieren unidimensionalidad en los reactivos que lo conforman.

Procedimiento. En la Etapa 1 se describen los procedimientos para la obtención de propiedades psicométricas iniciales con el análisis de unidimensionalidad y el AFE, mientras que la Etapa 2 sobre la validez de constructo del CECD.

Etapa 1. Obtención de propiedades psicométricas iniciales

Fase 1. Análisis de unidimensionalidad. Con el fin de determinar si la totalidad de los reactivos que integran el instrumento se encuentren evaluando un único rasgo latente se realizó el análisis de unidimensionalidad con la metodología de Rasch Masters. De inicio se prepararon los archivos de trabajo de los 199,967 participantes, donde se realizaron los análisis descriptivos como procedimiento de rutina en el software Statistical Package for the Social Sciences (SPSS) versión 17.0. Posteriormente se estimaron las propiedades del cuestionario con el programa Winsteps® Rasch Measurement Versión 3.70.0.2 (Linacre, 2009) para con ello conocer el comportamiento de los reactivos en cuanto a la discriminación, dificultad e índices de ajuste.

Fase 2. Análisis factorial exploratorio. Con el propósito de identificar los factores que subyacen en el CECD se efectuó un AFE con el software SPSS versión 17. Siguiendo las fases referidas por Martínez, Hernández y Hernández (2006), se preparó de manera inicial la base de datos, se determinó el tipo de extracción y rotación de los factores, y por último se interpretaron los factores a la luz de dos criterios: a) la carga factorial, la presencia de una carga factorial mayor en uno de los factores sería indicativo de que la variable es más representativa del factor (Zamora, Monroy y Chávez, 2009) y, b), la contrastación del modelo teórico que subyace al instrumento, en este caso se contrastó con el MECD a través de la Retícula de planeación de la segunda versión del CECD de Luna et al. (2012), donde se le asignó un nombre a la agrupación de las variables observadas que reflejara con mayor precisión el aspecto que representan. Asimismo, en esta fase se obtuvieron índices de consistencia interna del cuestionario y de los factores observados.

Etapa 2. Validez de constructo del CECD

Se realizó el AFC bajo la metodología del modelamiento de ecuaciones estructurales que permiten confirmar la estructura factorial del CECD en la muestra de la UABC con el programa de cómputo para el análisis de datos Stata (StataCorp., 2011). Se realizaron las operaciones analíticas sugeridas por Kline (2011) para este tipo de metodología: especificación del modelo, identificación y estimación de los parámetros del sistema de ecuaciones estructurales, evaluación de los criterios de calidad de ajuste (con el estadístico chi cuadrada, Raíz del residuo cuadrático promedio de aproximación [RMSEA], Raíz del residuo cuadrático promedio estandarizado [SRMR], Índice de bondad de ajuste comparativo [CFI], Índice de Tucker-Lewis [TLI]), y modificación del modelo de medición.

IV. Resultados

Los resultados se estructuraron en función de cada una de las etapas y fases del proceso de investigación. Así, a continuación se describen los hallazgos de la Etapa 1 y las fases: análisis de unidimensionalidad y AFE; Etapa 2, que comprende el AFC.

Etapa 1. Obtención de propiedades psicométricas iniciales

Fase 1. Análisis de unidimensionalidad. Se prepararon los archivos de trabajo para los análisis correspondientes al análisis Rasch para con ello obtener la distribución de frecuencias y estadígrafos básicos (medias y desviaciones estándar), así como la estimación de las propiedades del cuestionario de medición.

En relación a la estimación de las propiedades del cuestionario, de los 35 reactivos que lo componen, 33 registraron niveles aceptables en discriminación del reactivo, y tres no se ajustan a los límites críticos esperados de discriminación, el reactivo 34 (Utiliza diversos recursos didácticos en clase [por ejemplo presentaciones en computadora, videos, fotos, diagramas, etc.]), el 35 (Incorpora en sus clases el uso de la tecnología de la información y la comunicación [por ej. internet, uso de software, etc.]), y 1 (Menciona la relación de algunos contenidos del curso con temas de otras materias del plan de estudios), los cuales deben aproximarse a 1.0 (Linacre, 2014).

En cuanto al criterio de la dificultad del reactivo la totalidad de los reactivos se apegaron a la expectativa. Mientras que, como indicador de ajuste global se empleó el estadístico MNSQ y sus valores de ajuste en INFIT y en OUTFIT, todos los reactivos presentaron valores en los parámetros aceptables (0.60 a 1.40 lógitos) a excepción de los reactivos 34, 35 y 1 que presentaron problemas de ajuste.

Se replicó el análisis de unidimensionalidad prescindiendo de los reactivos 34, 35 y 1, además, con el propósito de que los resultados no se encontraran influenciados por valores atípicos en los subsecuentes análisis se decidió excluir los cuestionarios con varianza cero.

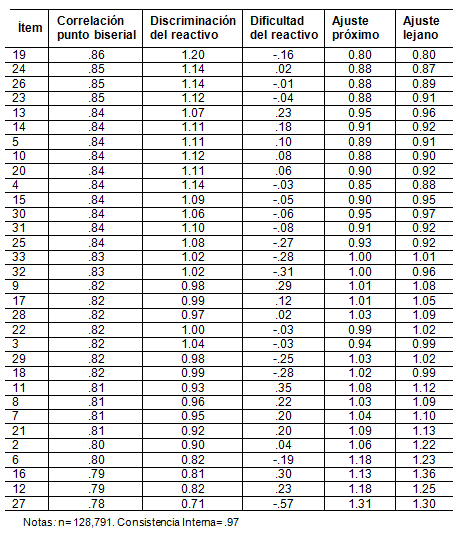

Por lo tanto, con una muestra de 128,791 cuestionarios y el instrumento con 32 reactivos, se concluye a partir de los resultados (ver Tabla II) que los ítems se comportaron en el análisis según las expectativas del modelo Rasch Masters. Se alcanzó una confiabilidad alta del orden de .97, igual a la obtenida en el análisis previo, por tanto se procede al AFE.

Tabla II. Ajuste de los valores de los criterios del Análisis de Unidimensionalidad Final

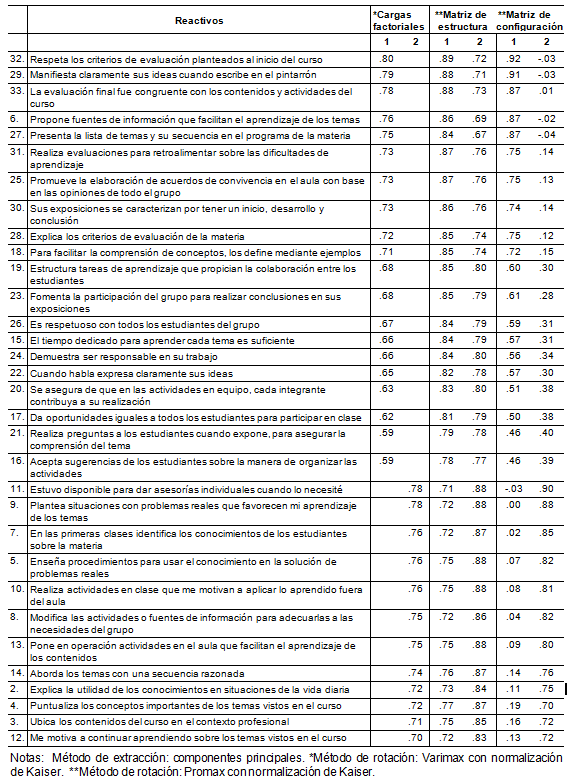

Fase 2. Análisis Factorial Exploratorio. Con una muestra de 66,148 cuestionarios se procedió a la preparación inicial de los datos, se obtuvieron valores de media aritmética, desviación estándar y número de casos, así como la matriz de correlaciones entre las variables, donde los índices de asociación van de .858 a .603, todas las correlaciones resultaron estadísticamente significativas. Se realizó el análisis con el método de extracción de componentes principales, con rotación varimax y promax con normalización Kaiser, en versión libre.

Finalmente, en relación a la interpretación de los factores, los resultados de la rotación varimax como la promax arrojaron ambos dos factores, con una agrupación idéntica de los reactivos en cada factor, con cargas factoriales interpretables e idénticos valores de varianza explicada (ver Tabla III). El criterio de raíz latente y criterio de contraste de caída permite justificar el número de factores que es factible considerar en la interpretación. El primer criterio considera significativos raíces latentes mayores a uno. En este caso los dos factores cumplen este criterio al reportar 22.85 eigenvalores en el Factor 1 y 1.15 en el Factor 2; y con el criterio de contraste de caída se obtiene el máximo de factores que deben considerarse en la interpretación.

La solución factorial agrupó a los 32 reactivos en dos factores interpretables, conformado por un porcentaje de varianza del 71.43% en el Factor 1 y de 3.59% en el Factor 2, con un 75.02% de la varianza total explicada. Asimismo, la totalidad de los reactivos cumplió con el criterio de decisión de la prueba de comunalidades de los reactivos al registrarse por arriba de .50 y considerarse dentro de un factor.

Tabla III. Análisis Factorial Exploratorio del CECD

Se encontró correspondencia con el MECD a partir de la Retícula de planeación de la segunda versión del CECD (Luna et al. 2012), por lo tanto, el Factor 1 se denominó Conducción y valoración del proceso de enseñanza-aprendizaje. Mientras que el Factor 2 se nombró Planeación y gestión del proceso de enseñanza-aprendizaje.

La confiabilidad del instrumento en esta solución factorial se estimó a través del índice alpha de Cronbach, la cual resultó .98 con el total de los reactivos, en el Factor 1 fue del orden de .98 en y en el Factor 2 de .97, lo que indica valores altos según los diversos sistemas de referencia.

Etapa 2. Validez de constructo del CECD

Con base en el modelo teórico-hipotético producto del AFE se especificó para comprobar que la disposición de las relaciones en los datos observados mostrara un ajuste adecuado. Seguido de la identificación del modelo y estimación de los parámetros del sistema de ecuaciones estructurales, verificando que el software no reportara dificultades para estimar parámetros e interpretando los resultados. Dado que los valores no mostraron el ajuste esperado, se utilizaron los recursos de revisión para obtener una re-especificación de las relaciones postuladas en el modelo original y con ello mejorar el ajuste. La primera estrategia utilizada fue disminuir el tamaño de la muestra (de 67,111 a 462), dado que algunos índices de ajuste son sensibles al tamaño de muestra, como la chi cuadrada (Hair, Anderson, Tatham y Black, 1999; Hooper, Coughlan y Mullen, 2008; Joreskog y Sorbom, 1982; Stapleton, 1997) y el CFI (Hooper et al. 2008).

De manera general, como se describe en la tabla IV el modelo del CECD posterior a la re-especificación mejoró los índices de bondad de ajuste, mostró valores aceptables en todos los índices a excepción de la chi cuadrada que permaneció con valores fuera del límite crítico.

Tabla IV. Indicadores de ajuste del modelo de medición

Entre las bondades del modelo re-especificado de la muestra de la UABC se encuentran la estabilidad de su estructura factorial, representación de todas las subdimensiones del MECD que le subyace, con lo cual se fundamenta la congruencia con dicho modelo teórico. En la tabla V se enuncian los factores y reactivos del modelo con 25 reactivos.

Tabla V. Modelo del CECD compuesto por 25 reactivos

En suma, el modelo re-especificado

de la muestra de la UABC refleja parsimonia sin perjudicar

sustancialmente el ajuste del modelo de medición, puesto que los valores

obtenidos en los diferentes indicadores de ajuste revelan un buen ajuste aproximado.

Además, con el criterio de corte de Hu y Bentler (1999) y, Kim y Bentler,

(2006) combinando el RMSEA y el SRMR,

el modelo con 25 reactivos producto de la re-especificación se valida.

Por lo tanto, los hallazgos del AFC con la metodología

de modelamiento de ecuaciones estructurales permiten confirmar la estructura

interna derivada del AFE. El anexo

1 presenta el cuestionario.

V. Discusión

En relación al sustento teórico de los instrumentos de medición,

los especialistas de la psicometría (Borsboom, 2006) y del desarrollo

de cuestionarios de opinión de evaluación docente (Marsh, 2007;

Marsh y Dunkin, 1997; Marsh y Roche, 1993) coinciden en la escasa fundamentación

en una teoría que presentan y la exigua utilización de metodologías,

como el análisis factorial en la acumulación de evidencias de

validez. En este sentido, el CECD con base en la opinión

estudiantil se encuentra desarrollado desde el enfoque de enseñanza por

competencia, con una aproximación constructivista, sociocultural y situada

de las competencias, principios que definen el MECD que

subyace en el instrumento (Luna et al., 2012).

En lo que respecta a la evaluación de las competencias en el contexto académico, se ha abordado desde dos perspectivas: una global o integradora y otra por medio de indicadores. La construcción del CECD se dio desde esta última perspectiva, con las aportaciones de Denyer et al. (2007), autores que sostienen que es posible realizar la evaluación de las competencias a partir de criterios que desglosen las competencias en indicadores. Los resultados obtenidos en el presente trabajo contribuyen con fundamentos psicométricos y teóricos al ámbito de la enseñanza basada en competencias y su evaluación, basada en la opinión de los alumnos.

La aportación de este instrumento de medición de la docencia responde a tres aspectos, a los componentes que son considerados importantes para los estudiantes de la UABC, a las áreas que la literatura reporta como relevantes, y a los tres momentos del MECD.

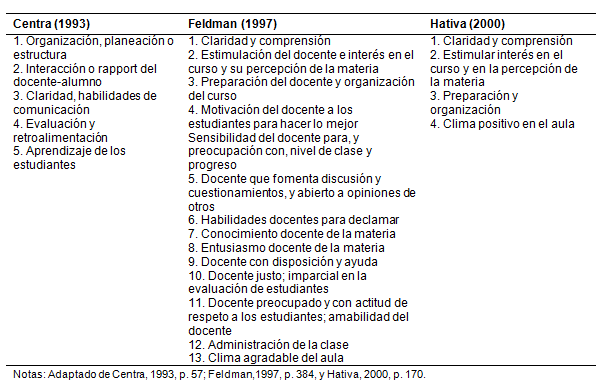

En relación a las dimensiones que la literatura reporta como relevantes, la configuración del CECD concuerda con gran parte de las dimensiones planteadas por Feldman (1997), Centra (1993) y Hativa (2000), como se aprecia en la tabla VI.

Tabla VI. Dimensiones de la evaluación docente que se ven reflejadas en el CECD

El CECD constituye un instrumento de evaluación de la docencia congruente con el modelo de enseñanza por competencias que conduce a evaluaciones congruentes con este modelo de enseñanza.

Referencias

Borsboom, D. (2006). The attack of the psychometricians. Psychometrika, 71(3), 425-440. doi: 10.1007/S11336-006-1447-6

Cano, M. E. (2008). La evaluación por competencias en la educación superior. Profesorado. Revista de currículum y formación del profesorado, 12(3). Universidad de Granada Campus Universitario Cartuja, España.

Centra, J. (1993). Reflective faculty evaluation: enhancing teaching and determining faculty effectiveness. Nueva York: Jossey-Bass.

Denyer, M., Furnemont, J., Poulain, R. y Vanloubbeeck, G. (2007). Las competencias en la educación, un balance. México: Fondo de Cultura Económica.

Feldman, K. (1997). Identifying exemplary teachers and teaching: evidence from student ratings. En R. P. Perry y J. C. Smart (Eds.), Effective teaching in higher education: Research and practice (pp. 368-395). Nueva York: Agathon Press.

García-Cabrero, B., Loredo, J., Luna, E. y Rueda, M. (2008). Modelo de evaluación de competencias docentes para la educación media y superior. Revista Iberoamericana de Evaluación Educativa, 1(3e), 96-108. Recuperado de http://rinace.net/riee/numeros/vol1-num3_e/art8.pdf

García-Cabrero, B., Loredo, J., Luna, E. y Rueda, M. (2014). Competencias Docentes en Educación Media y Superior. Desarrollo y Validación de un Modelo de Evaluación. México: Universidad Autónoma de Baja California, Juan Pablos Editor.

Hair, J., Anderson, R., Tatham, R. y Black, W. (1999). Análisis Multivariante. Madrid: Pearson/Prentice Hall.

Hativa, N. (2000). Teaching for effective learning in higher education. Holanda: Kluwer Academic Publishers.

Hooper, D., Coughlan, J. y Mullen, M. (2008). Structural Equation Modelling: Guidelines for Determining Model Fit. Electronic Journal of Business Research Methods, 6(1), 53-60.

Hu, L. y Bentler, P. (1999). Cutoff criteria for fit indexes in covariance structure analysis: Conventional criteria versus new alternatives. Structural Equation Modeling, 6(1), 1-55.

Joreskog, K. y Sorbom, D. (1982). Recent developments in structural equation modeling. Journal of Marketing Research, 19, 404-416.

Kim, K. y Bentler, P. (2006). Data modeling: Structural Equation Modeling. En J. Green, G. Camili y P. Elmore (Eds.), Handbook of Complementary Methods in Education Research (pp. 161-175). EE.UU.: American Education Research Association.

Kline, R. (2011). Principles and practice of structural equation modeling. EE.UU.: Guillford Press.

Linacre, J. (2009). Winsteps. Rasch measurement computer program (Versión 3.70.0.2) [Software de cómputo]. Illinois, EE.UU.:Winsteps.com

Linacre, J. (2014). A user’s Guide to Winsteps ministep. Rasch-Model Computer Programs. Program Manual 3.70.0. Recuperado de http://www.winsteps.com/a/facets-manual.pdf

Luna, E. (2000). Aspectos implícitos sobre la enseñanza reflejados en los cuestionarios de evaluación de la docencia. En M. Rueda y F. Díaz-Barriga (Eds.), Evaluación de la docencia. Perspectivas actuales (pp. 63-83). México: Paidós.

Luna, E., Calderón, N., Caso, J. y Cordero, G. (2012). Desarrollo y validación de un cuestionario de evaluación de la competencia docente con base en la opinión de los estudiantes. En E. Cisneros-Cohernour, B. García-Cabrero, E. Luna y R. Marín (Eds.), Evaluación de competencias docentes en la Educación Superior (pp.119-158). México: Red para el Desarrollo y Evaluación de Competencias Académicas, Juan Pablos Editor.

Marsh, H. (2007). Students’ evaluations of university teaching: Dimensionality, reliability, validity, potential biases and usefulness. En R. P. Perry y J. C. Smart (Eds.), The scholarship of teaching and learning in higher education: an evidence-based perspective (pp. 319-383). Holanda: Springer.

Marsh, H. y Dunkin, M. (1997). Students’ evaluations of university teaching: A multidimensional perspective. En R. P. Perry y J. C. Smart (Eds.), Effective teaching in higher education: research and practice (pp. 241-320). Nueva York: Agathon Press.

Marsh, H. y Roche, L. (1993). The use of students’ evaluations and an individually structured intervention to enhance university teaching effectiveness. American Educational Research Journal, 30(1), 217-251. doi: 110.3102/00028312030001217

Martínez, M., Hernández, M. y Hernández, M. (2006). Psicometría. España: Alianza.

Perrenoud, P. (2004). Diez nuevas competencias para enseñar. Barcelona: Graó.

Red Iberoamericana de Investigadores de la Evaluación de la Docencia

(2008). Reflexiones sobre el diseño y puesta en marcha de programas de

evaluación de la docencia.

Revista Iberoamericana de Evaluación Educativa, 1(3),

163-168. Recuperado de http://www.rinace.net

/riee/numeros/vol1-num3_e/reflexiones.pdf

Rueda, M., Luna, E., García, B. y Loredo, J. (2011). Resultados y recomendaciones. En M. Rueda (Ed.) ¿Evaluar para controlar o para mejorar? Valoración del desempeño docente en las universidades (pp. 197-222). México: UNAM y Bonilla Artigas.

Seldin, P. (1993). The use and abuse of student ratings of professors. The Chronicle of Higher Education, 39(46), 40.

Stapleton, C. (enero, 1997). Basic concepts and procedures of confirmatory factor analysis. Trabajo presentado en la conferencia de la Annual Meeting of the Southwest Educational Research Association, Texas. Recuperado de http://www.eric.ed.gov/PDFS/ED 407416.pdf

StataCorp (2011). Stata: Release 12. Statistical Sortware. College Station, TX: StataCorp LP.

Theall, M. y Franklin, J. (2000). Creating responsive student ratings systems to improve evaluation practice. New Directions for Teaching and Learning, 83, 95-107.

Zabalza, M. A. (2005). Competencias docentes. Documento presentado en la Pontificia Universidad Javeriana de Cali, Colombia. Recuperado de http://portales.puj.edu.co/didactica/Archivos/Competencias%20docentes.pdf

Zamora, S., Monroy, L. y Chávez, C. (2009). Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas. Cuaderno técnico 6. México: Centro Nacional de Evaluación para la Educación Superior, A.C.

Cómo citar: Luna, E. y Reyes,

E. (2015). Validación de constructo de un cuestionario de evaluación

de la competencia docente. Revista Electrónica de Investigación

Educativa, 17(3), 13-27. Recuperado de http://redie.uabc.mx/vol17no3/contenido-luna-pinuelas.html